- Esenciales

- Empezando

- Agent

- API

- Rastreo de APM

- Contenedores

- Dashboards

- Monitorización de bases de datos

- Datadog

- Sitio web de Datadog

- DevSecOps

- Gestión de incidencias

- Integraciones

- Internal Developer Portal

- Logs

- Monitores

- OpenTelemetry

- Generador de perfiles

- Session Replay

- Security

- Serverless para Lambda AWS

- Software Delivery

- Monitorización Synthetic

- Etiquetas (tags)

- Workflow Automation

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Build an Integration with Datadog

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un dashboard de integración

- Create a Monitor Template

- Crear una regla de detección Cloud SIEM

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- OpenTelemetry

- Administrator's Guide

- API

- Partners

- Aplicación móvil de Datadog

- DDSQL Reference

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Reference Tables

- Hojas

- Monitores y alertas

- Watchdog

- Métricas

- Bits AI

- Internal Developer Portal

- Error Tracking

- Explorador

- Estados de problemas

- Detección de regresión

- Suspected Causes

- Error Grouping

- Bits AI Dev Agent

- Monitores

- Issue Correlation

- Identificar confirmaciones sospechosas

- Auto Assign

- Issue Team Ownership

- Rastrear errores del navegador y móviles

- Rastrear errores de backend

- Manage Data Collection

- Solucionar problemas

- Guides

- Change Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Status Pages

- Gestión de eventos

- Gestión de casos

- Actions & Remediations

- Infraestructura

- Cloudcraft

- Catálogo de recursos

- Universal Service Monitoring

- Hosts

- Contenedores

- Processes

- Serverless

- Monitorización de red

- Cloud Cost

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Recommendations

- Code Origin for Spans

- Observabilidad del servicio

- Endpoint Observability

- Instrumentación dinámica

- Live Debugger

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Límites de tasa del Agent

- Métricas de APM del Agent

- Uso de recursos del Agent

- Logs correlacionados

- Stacks tecnológicos de llamada en profundidad PHP 5

- Herramienta de diagnóstico de .NET

- Cuantificación de APM

- Go Compile-Time Instrumentation

- Logs de inicio del rastreador

- Logs de depuración del rastreador

- Errores de conexión

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Setting Up Amazon DocumentDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Exploring Database Schemas

- Exploring Recommendations

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Experiencia digital

- Real User Monitoring

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Análisis de productos

- Entrega de software

- CI Visibility

- CD Visibility

- Deployment Gates

- Test Visibility

- Configuración

- Network Settings

- Tests en contenedores

- Repositories

- Explorador

- Monitores

- Test Health

- Flaky Test Management

- Working with Flaky Tests

- Test Impact Analysis

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Code Coverage

- Quality Gates

- Métricas de DORA

- Feature Flags

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Code Security

- Cloud Security Management

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- CloudPrem

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Ayuda

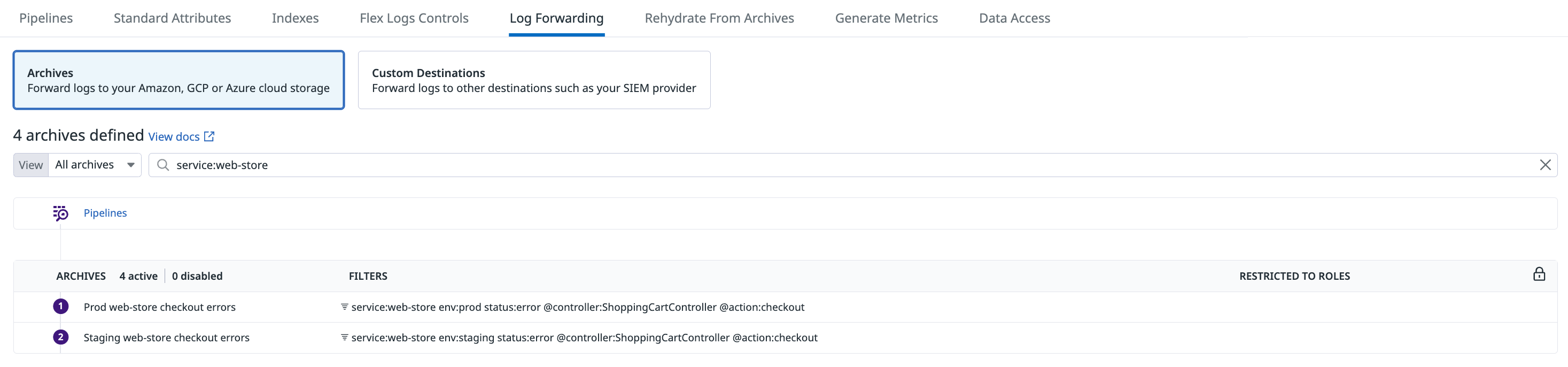

Archivos de log

Información general

Configura tu cuenta de Datadog para reenviar todos los logs ingestados (ya sea que esté indexado o no) a un sistema de almacenamiento en la nube de tu propiedad. Conserva tus logs en un archivo optimizado para el almacenamiento durante más tiempo y cumple los requisitos de conformidad, al tiempo que mantienes la auditabilidad para investigaciones ad hoc, con Recuperación.

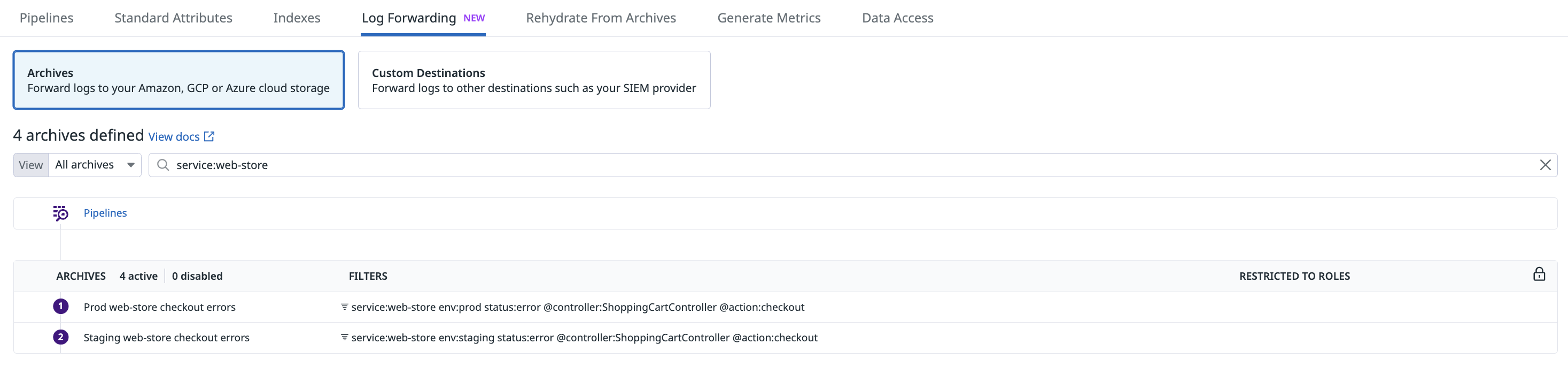

Ve a la page (página) Log Archiving & Forwarding (Archivo y reenvío de logs) para configurar un archivo para reenviar loga su propio bucket de almacenamiento alojado en la nube.

- Si aún no lo has hecho, configura una [integración] de Datadog (#set-up-an-integration) para tu proveedor de nube.

- Crea un bucket de almacenamiento.

- Establece permisos en

readowriteen ese archivo. - Enruta tus logs hacia y desde ese archivo.

- Establece la configuración avanzada como cifrado, clase de almacenamiento y etiquetas (tags).

- Valida tu configuración y busca posibles errores de configuración que Datadog podría detectar por ti.

Consulta cómo archivar tus logs con Pipelines de observabilidad si deseas dirigir tus logs a un archivo optimizado para el almacenamiento directamente desde tu entorno.

Las siguientes métricas informan sobre los logs que se han archivado correctamente, incluidos los logs que se enviaron correctamente tras reintentos.

- datadog.archives.logs.bytes

- datadog.archives.logs.count

Configurar un archivo

Establecer una integración

Si aún no está configurada, configura la integración de AWS para la cuenta de AWS que contiene tu bucket de S3.

- En el caso general, se trata de crear un rol que Datadog pueda utilizar para integrarse con AWS S3.

- En el caso específico de las cuentas de AWS China, utiliza claves de acceso como alternativa a la delegación de roles.

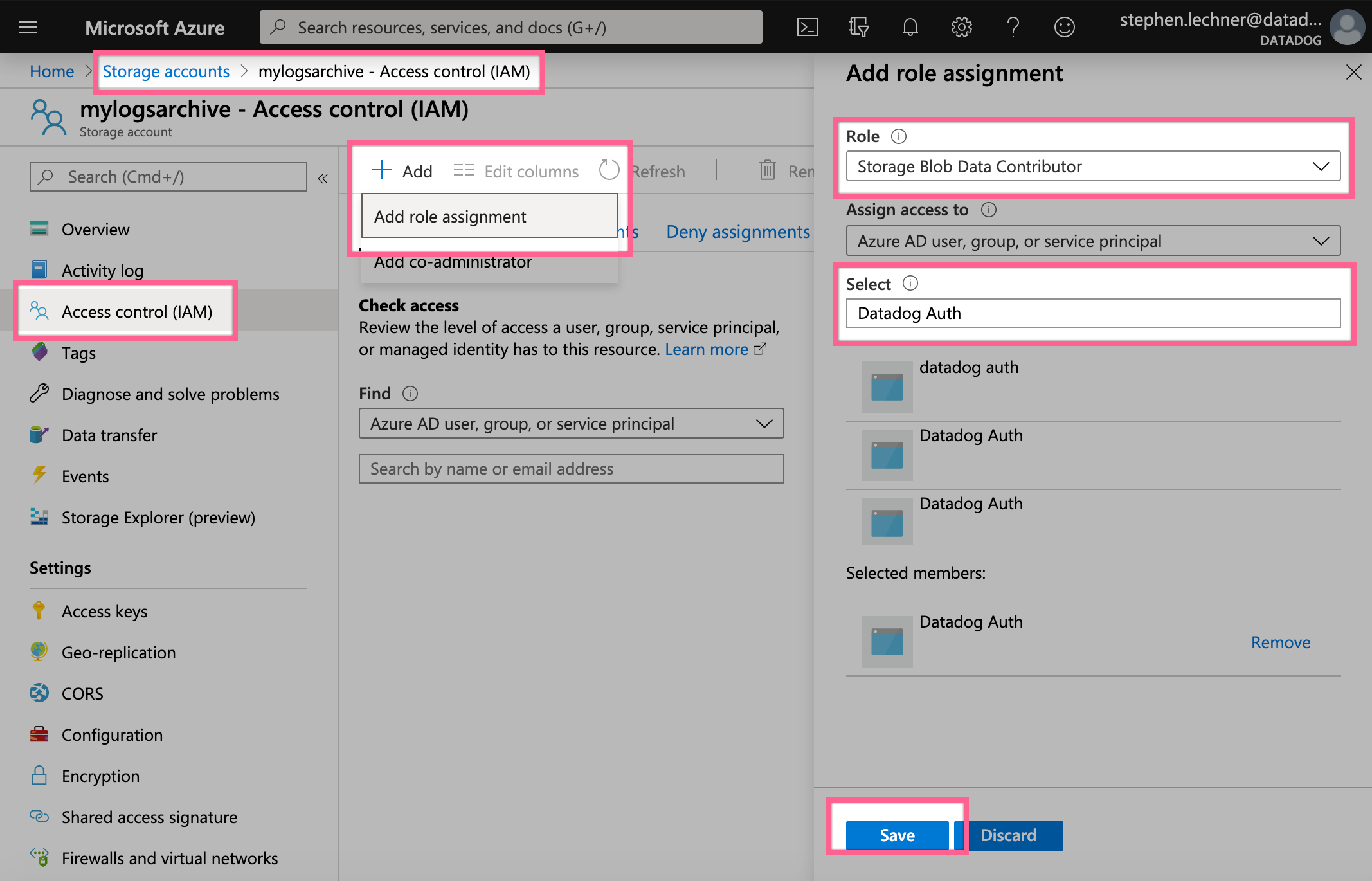

Configura la integración de Azure dentro de la suscripción que contiene tu nueva cuenta de almacenamiento, si aún no lo has hecho. Esto implica crear un registro de aplicación que Datadog pueda utilizar para integrarla.

Nota: El archivado en Azure ChinaCloud y Azure GermanyCloud no es compatible. El archivado en Azure GovCloud es compatible con la versión preliminar. Para solicitar acceso, ponte en contacto con el servicio de asistencia de Datadog.

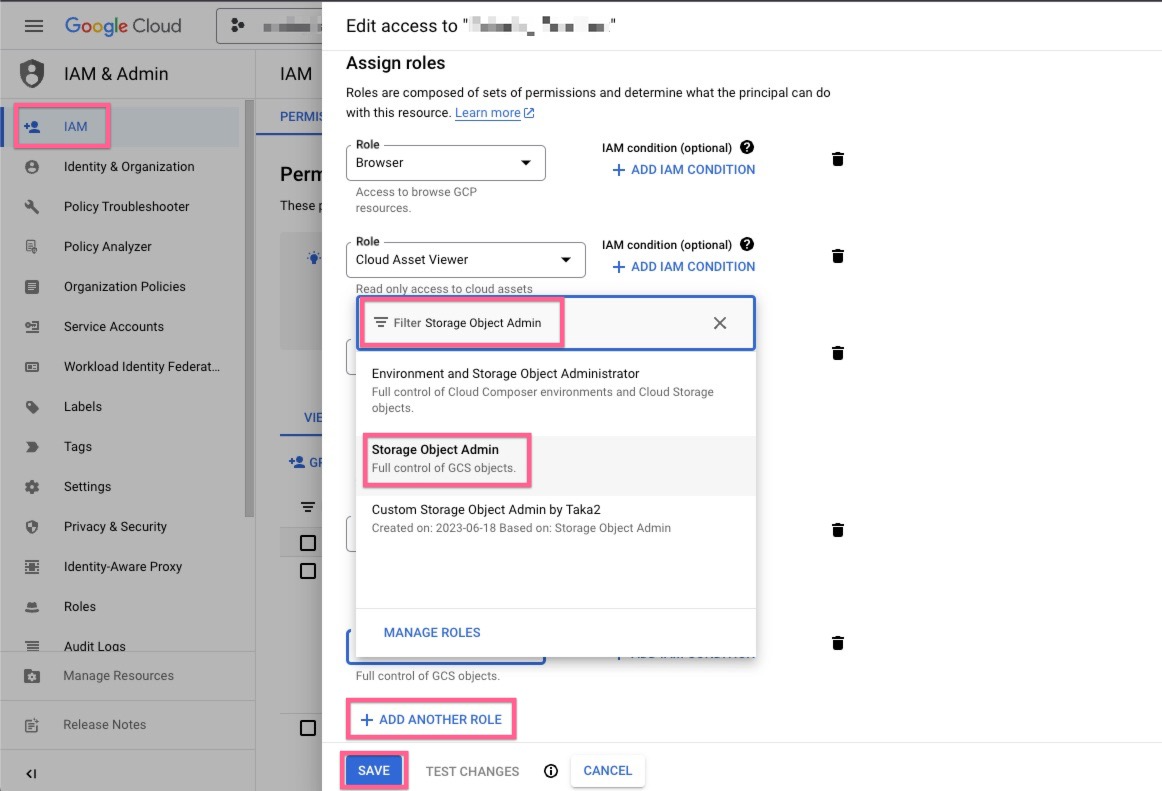

Configura la integración de Google Cloud para el proyecto que contiene tu bucket de almacenamiento de GCS, si aún no lo has hecho. Esto implica crear una cuenta de servicio de Google Cloud que Datadog pueda utilizar para integrarla.

Crear un bucket de almacenamiento

El envío de logs a un archivo queda fuera del entorno de Datadog GovCloud, que está fuera del control de Datadog. Datadog no será responsable de ningún log que haya salido del entorno de Datadog GovCloud, incluidas, entre otras, las obligaciones o requisitos que el usuario pueda tener en relación con FedRAMP, DoD Impact Levels, ITAR, cumplimiento de las normas de exportación, residencia de datos o normativas similares aplicables a dichos logs.

Entra en tu consola de AWS y crea un bucket de S3 al que enviar tus archivos.

Los archivos de Datadog no admiten nombres de bucket con puntos (.) cuando se integran con un endpoint de FIPS de S3 que se basa en el direccionamiento de estilo de host virtual. Obtén más información en la documentación de AWS. AWS FIPS y AWS Virtual Hosting.

Notas:

- No pongas tu bucket a disposición del público.

- Para los sitios US1, US3 y US5, consulta Precios de AWS para conocer las tarifas de transferencia de datos entre regiones y cómo pueden verse afectados los costes de almacenamiento en la nube. Considera la posibilidad de crear tu bucket de almacenamiento en

us-east-1para gestionar tus tarifas de transferencia de datos entre regiones.

- Ve a tu Portal de Azure y crea una cuenta de almacenamiento a la que enviar tus archivos. Asigna un nombre a tu cuenta de almacenamiento, selecciona el tipo de cuenta de rendimiento estándar o Block blobs premium y selecciona el nivel de acceso hot (activo) o cool (inactivo).

- Crea un servicio de contenedor en esa cuenta de almacenamiento. Toma nota del nombre del contenedor ya que necesitarás añadirlo en la Página de archivo de Datadog.

Nota: No establezcas políticas de inmutabilidad porque los últimos datos deben ser reescritos en algunos casos poco frecuentes (típicamente un tiempo de inactividad).

Accede a tu cuenta de Google Cloud y crea un bucket de GCS al que enviar tus archivos. En Choose how to control access to objects (Elige cómo controlar el acceso a los objetos), selecciona Set object-level and bucket-level permissions (Configurar permisos a nivel de objeto y a nivel de bucket).

Nota: No añadas una política de retención porque los últimos datos deben ser reescritos en algunos casos poco frecuentes (típicamente un tiempo de inactividad).

Establecer permisos

Solo los usuarios de Datadog con el permisologs_write_archive pueden crear, modificar o eliminar configuraciones de archivo de log.

Crear una política con las siguientes declaraciones de permiso:

{ "Version": "2012-10-17", "Statement": [ { "Sid": "DatadogUploadAndRehydrateLogArchives", "Effect": "Allow", "Action": ["s3:PutObject", "s3:GetObject"], "Resource": [ "arn:aws:s3:::<MY_BUCKET_NAME_1_/_MY_OPTIONAL_BUCKET_PATH_1>/*", "arn:aws:s3:::<MY_BUCKET_NAME_2_/_MY_OPTIONAL_BUCKET_PATH_2>/*" ] }, { "Sid": "DatadogRehydrateLogArchivesListBucket", "Effect": "Allow", "Action": "s3:ListBucket", "Resource": [ "arn:aws:s3:::<MY_BUCKET_NAME_1>", "arn:aws:s3:::<MY_BUCKET_NAME_2>" ] } ] }- Los permisos

GetObjectyListBucketpermiten recuperar a partir de archivos. - El permiso

PutObjectes suficiente para cargar archivos. - Asegúrate de que el valor del recurso en las acciones

s3:PutObjectys3:GetObjecttermina con/*porque estos permisos se aplican a objetos dentro de los buckets.

- Los permisos

Edita los nombres de los buckets.

Opcionalmente, especifica las rutas que contienen tus archivos de log.

Adjunta la nueva política al rol de integración de Datadog.

- Ve a Roles en la consola IAM en AWS.

- Localiza el rol utilizado por la integración Datadog. Por defecto se llama DatadogIntegrationRole, pero el nombre puede variar si tu organización le ha cambiado el nombre. Haz clic en el nombre del rol para abrir la página de resumen del rol.

- Haz clic en Add permissions (Añadir permisos) y, luego, en Attach policies (Adjuntar políticas).

- Introduce el nombre de la política creada anteriormente.

- Haz clic en Attach policies (Adjuntar políticas).

- Concede a la aplicación de Datadog el permiso para escribir y recuperar desde tu cuenta de almacenamiento.

- Selecciona tu cuenta de almacenamiento en la página Cuentas de almacenamiento, ve a Access Control (IAM) (Control de acceso (IAM)) y seleccionaAdd -> Add Role Assignment (Añadir -> Añadir asignación del rol).

- Introduce el rol denominado Storage Blob Data Contributor, selecciona la aplicación de Datadog que creaste para integrarse con Azure y selecciona guardar.

Concede a tu cuenta de servicio de Datadog Google Cloud permisos para escribir tus archivos en tu bucket.

Selecciona la entidad principal de la cuenta de servicio de Datadog Google Cloud en la página de administración de Google Cloud IAM y selecciona Edit principal (Editar entidad principal).

Haz clic en ADD ANOTHER ROLE (AÑADIR OTRO ROL), selecciona el rol Storage Object Admin y selecciona guardar.

Dirige tus logs a un bucket

Ve a la page (pagina) Archivo y reenvío de logs y selecciona Add new archive (Añadir nuevo archivo) en la pestaña Archives (Archivos).

Notas:

- Solo los usuarios de Datadog con el permiso

logs_write_archivepueden completar este paso y el siguiente. - Para archivar logs en Azure Blob Storage es necesario registrarse en la aplicación. Consulta las instrucciones en la página de integración de Azure, y establece el “sitio” en la parte derecha de la página de documentación en “US”. Los Registros de aplicación creados con fines de archivado solo necesitan el rol “Storage Blob Data Contributor”. Si tu bucket de almacenamiento se encuentra en una suscripción que está siendo supervisada a través de un recurso de Datadog, se mostrará una advertencia acerca de que el Registro de aplicación es redundante. Puedes ignorar esta advertencia.

- Si tu bucket restringe el acceso de red a las IP especificadas, añade las IP de los webhooks de IP ranges list a la lista de permitidos.

- Para el sitio US1-FED, puedes configurar Datadog para que envíe los logs a un destino fuera del entorno de GovCloud de Datadog. Datadog no es responsable de ningún log que salga del entorno de GovCloud de Datadog. Además, Datadog no es responsable de ninguna obligación o requisito que puedas tener en relación con FedRAMP, DoD Impact Levels, ITAR, cumplimiento de las normas de exportación, residencia de datos o normativas similares aplicables a estos logs una vez que abandonan el entorno de GovCloud.

| Servicio | Pasos |

|---|---|

| Amazon S3 | - Selecciona la combinación de la cuenta y rol de AWS adecuada para tu bucket de S3. - Introduce el nombre de tu bucket. Opcional: introduce un directorio prefijo para todo el contenido de tus archivos de log. |

| Almacenamiento de Azure | - Selecciona el tipo de archivo Azure Storage (Almacenamiento de Azure), y el inquilino y cliente de Azure para la aplicación de Datadog que tiene el rol Storage Blob Data Contributor en tu cuenta de almacenamiento. - Introduce el nombre de tu cuenta de almacenamiento y el nombre de contenedor para tu archivo. Opcional: introduce un directorio prefijo para todo el contenido de tus archivos de log. |

| Google Cloud Storage | - Seleccione el tipo de archivo Google Cloud Storage (Almacenamiento de Google Cloud) y la cuenta de servicio de GCS que tiene permisos para escribir en tu bucket de almacenamiento. - Introduce el nombre de tu bucket. Opcional: introduce un directorio prefijo para todo el contenido de tus archivos de log. |

Configuración avanzada

Etiquetas de Datadog

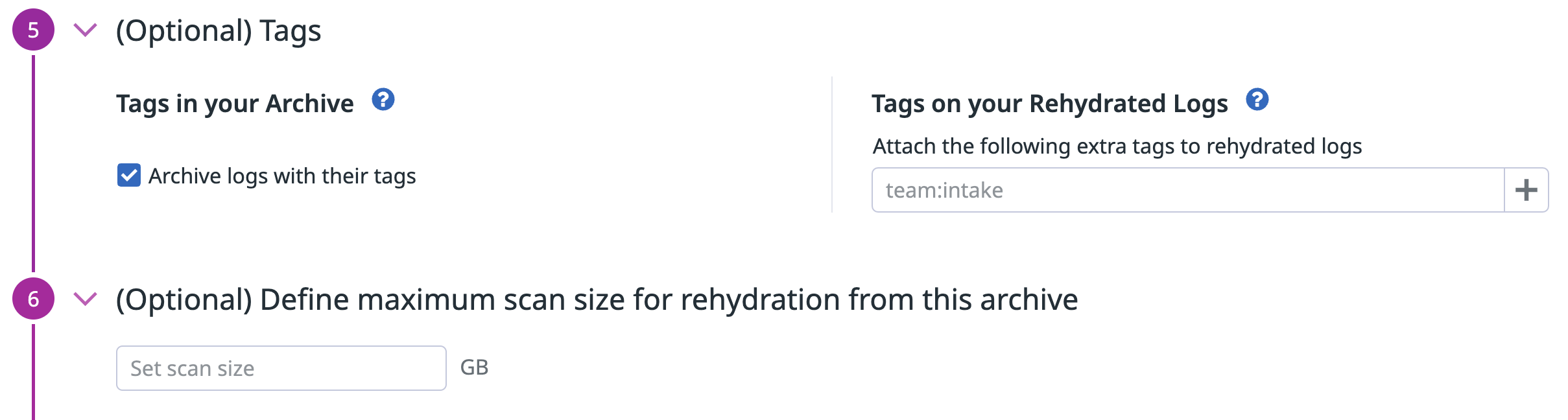

Utiliza este paso de configuración opcional para:

- Incluir todas las etiquetas de log en tus archivos (activado por defecto en todos los archivos nuevos). Nota: Esto aumenta el tamaño de los archivos resultantes.

- Añadir etiquetas en los logs recuperados de acuerdo con tu política de Consultas de restricción. Consulta el permiso

logs_read_data.

Definir el tamaño máximo de escaneado

Utiliza este paso de configuración opcional para definir el volumen máximo de datos de log (en GB) que se pueden escanear para la recuperación en tus archivos de log.

Para los archivos con un tamaño máximo de escaneado definido, todos los usuarios deben estimar el tamaño del escaneado antes de que se les permita iniciar una recuperación. Si el tamaño de escaneado estimado es superior al permitido para ese archivo, los usuarios deben reducir el intervalo en el que solicitan la recuperación. La reducción del intervalo reducirá el tamaño del escaneado y permitirá al usuario iniciar una recuperación.

Reglas del cortafuegos

No se admiten reglas de cortafuegos.

Clase de almacenamiento

Puedes seleccionar una clase de almacenamiento para tu archivo o establecer una configuración de ciclo de vida en tu bucket de S3 para realizar una transición automática de tus archivos de log a clases de almacenamiento óptimas.

La recuperación solo admite las siguientes clases de almacenamiento:

- S3 Standard

- S3 Standard-IA

- S3 One Zone-IA

- Recuperación instantánea de S3 Glacier

- S3 Intelligent-Tiering, sólo si los niveles opcionales de acceso asíncrono a los archivos están ambos desactivados.

Si deseas recuperar a partir de archivos de otra clase de almacenamiento, primero debes moverlos a una de las clases de almacenamiento admitidas mencionadas anteriormente.

El archivado y la recuperación solo admiten los siguientes niveles de acceso:

- Nivel de acceso activo

- Nivel de acceso inactivo

Si deseas recuperar a partir de archivos de otro nivel de acceso, primero debes moverlos a uno de los niveles admitidos mencionados anteriormente.

Archivo y rehidratación admite los siguientes niveles de acceso:

- Standard (Estándar)

- Nearline

- Coldline

- Archivo

Cifrado del lado del servidor (SSE) para archivos de S3

Al crear o actualizar un archivo de S3 en Datadog, puedes optar por configurar Advanced Encryption (Cifrado avanzado). Hay tres opciones disponibles en el menú desplegable Encryption Type (Tipo de cifrado):

- Cifrado predeterminado a nivel de bucket de S3 (predeterminado): Datadog no anula la configuración de cifrado predeterminado de tu bucket de S3.

- Claves gestionadas de Amazon S3: fuerza el cifrado del lado del servidor utilizando claves administradas de Amazon S3 (SSE-S3), independientemente del cifrado predeterminado del bucket de S3.

- AWS Key Management Service: fuerza el cifrado del lado del servidor utilizando una clave gestionada por el cliente (CMK) de AWS KMS, independientemente del cifrado predeterminado del bucket de S3. Deberás proporcionar el ARN de la CMK.

Cuando se selecciona esta opción, Datadog no especifica ningún encabezado de cifrado en la solicitud de carga. Se aplicará el cifrado predeterminado de tu bucket de S3.

Para configurar o comprobar la configuración del cifrado de tu bucket S3:

- Navega hasta tu bucket de S3.

- Haz clic en la pestaña Propiedades.

- En la sección Default Encryption (Cifrado por defecto), configura o confirma el tipo de cifrado. Si tu cifrado utiliza AWS KMS, asegúrate de que tienes una CMK válida y una política de CMK adjunta a tu CMK.

Esta opción garantiza que todos los objetos de archivo se carguen con SSE_S3, mediante claves administradas de Amazon S3. Esto sustituye cualquier configuración de cifrado predeterminada en el bucket de S3.

Esta opción garantiza que todos los objetos de archivo se carguen mediante una clave gestionada por el cliente (CMK) de AWS KMS. Esto sustituye cualquier configuración de cifrado predeterminada en el bucket de S3.

Asegúrate de haber completado los siguientes pasos para crear una CMK y una política de CMK válidas. A continuación, proporciona el ARN de CMK para configurar correctamente este tipo de cifrado.

- Crea tu CMK.

- Adjunta una política de CMK a tu CMK con el siguiente contenido, sustituyendo según corresponda el número de cuenta de AWS y el nombre de rol de Datadog IAM:

{

"Id": "key-consolepolicy-3",

"Version": "2012-10-17",

"Statement": [

{

"Sid": "Enable IAM User Permissions",

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::<MY_AWS_ACCOUNT_NUMBER>:root"

},

"Action": "kms:*",

"Resource": "*"

},

{

"Sid": "Allow use of the key",

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::<MY_AWS_ACCOUNT_NUMBER>:role/<MY_DATADOG_IAM_ROLE_NAME>"

},

"Action": [

"kms:Encrypt",

"kms:Decrypt",

"kms:ReEncrypt*",

"kms:GenerateDataKey*",

"kms:DescribeKey"

],

"Resource": "*"

},

{

"Sid": "Allow attachment of persistent resources",

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::<MY_AWS_ACCOUNT_NUMBER>:role/<MY_DATADOG_IAM_ROLE_NAME>"

},

"Action": [

"kms:CreateGrant",

"kms:ListGrants",

"kms:RevokeGrant"

],

"Resource": "*",

"Condition": {

"Bool": {

"kms:GrantIsForAWSResource": "true"

}

}

}

]

}

- Después de seleccionar AWS Key Management Service como tu Encryption Type (Tipo de cifrado) en Datadog, introduce tu ARN de la clave de AWS KMS.

Validación

Una vez que los ajustes del archivo se hayan configurado correctamente en tu cuenta de Datadog, tus pipelines de procesamiento comenzarán a enriquecer todos los logs que se ingieran en Datadog. Estos logs se reenvían posteriormente a tu archivo.

Sin embargo, después de crear o actualizar las configuraciones de los archivos, pueden pasar varios minutos antes de que se intente la siguiente carga de archivos. La frecuencia con la que se cargan los archivos puede variar. Consulta tu bucket de almacenamiento de nuevo en 15 minutos para asegurarte de que los archivos se están cargando correctamente desde tu cuenta de Datadog.

Después, si el archivo sigue en estado pendiente, comprueba tus filtros de inclusión para asegurarte de que la consulta es válida y coincide con eventos de log en Live Tail. Cuando Datadog no consigue cargar logs en un archivo externo, debido a cambios involuntarios en la configuración o los permisos, el archivo de log correspondiente aparece resaltado en la página de configuración.

Pasa el ratón por encima del archivo para ver los detalles del error y las acciones a realizar para resolver el problema. También se genera un evento en el Log Explorer. Puedes crear un monitor para estos eventos con el fin de detectar y solucionar fallos rápidamente.

Múltiples archivos

Si se definen múltiples archivos, los logs introducen el primer archivo en función del filtro.

Es importante ordenar los archivos con cuidado. Por ejemplo, si creas un primer archivo filtrado con la etiqueta env:prod y un segundo archivo sin ningún filtro (el equivalente a *), todos tus logs de producción irían a un bucket o ruta de almacenamiento, y el resto iría al otro.

Formato de los archivos

Los archivos de log que Datadog reenvía a tu bucket de almacenamiento están en formato JSON comprimido (.json.gz). Utilizando el prefijo que indiques (o / si no hay ninguno), los archivos se almacenan en una estructura de directorios que indica en qué fecha y a qué hora se generaron los archivos de almacenamiento, como la siguiente:

/my/bucket/prefix/dt=20180515/hour=14/archive_143201.1234.7dq1a9mnSya3bFotoErfxl.json.gz

/my/bucket/prefix/dt=<YYYYMMDD>/hour=<HH>/archive_<HHmmss.SSSS>.<DATADOG_ID>.json.gz

Esta estructura de directorios simplifica el proceso de consulta de tus archivos de log históricos en función de su fecha.

Referencias adicionales

Más enlaces, artículos y documentación útiles:

*Logging without Limits es una marca registrada de Datadog, Inc.