- Esenciales

- Empezando

- Agent

- API

- Rastreo de APM

- Contenedores

- Dashboards

- Monitorización de bases de datos

- Datadog

- Sitio web de Datadog

- DevSecOps

- Gestión de incidencias

- Integraciones

- Internal Developer Portal

- Logs

- Monitores

- OpenTelemetry

- Generador de perfiles

- Session Replay

- Security

- Serverless para Lambda AWS

- Software Delivery

- Monitorización Synthetic

- Etiquetas (tags)

- Workflow Automation

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Build an Integration with Datadog

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un dashboard de integración

- Create a Monitor Template

- Crear una regla de detección Cloud SIEM

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- OpenTelemetry

- Administrator's Guide

- API

- Partners

- Aplicación móvil de Datadog

- DDSQL Reference

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Reference Tables

- Hojas

- Monitores y alertas

- Watchdog

- Métricas

- Bits AI

- Internal Developer Portal

- Error Tracking

- Explorador

- Estados de problemas

- Detección de regresión

- Suspected Causes

- Error Grouping

- Bits AI Dev Agent

- Monitores

- Issue Correlation

- Identificar confirmaciones sospechosas

- Auto Assign

- Issue Team Ownership

- Rastrear errores del navegador y móviles

- Rastrear errores de backend

- Manage Data Collection

- Solucionar problemas

- Guides

- Change Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Status Pages

- Gestión de eventos

- Gestión de casos

- Actions & Remediations

- Infraestructura

- Cloudcraft

- Catálogo de recursos

- Universal Service Monitoring

- Hosts

- Contenedores

- Processes

- Serverless

- Monitorización de red

- Cloud Cost

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Recommendations

- Code Origin for Spans

- Observabilidad del servicio

- Endpoint Observability

- Instrumentación dinámica

- Live Debugger

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Límites de tasa del Agent

- Métricas de APM del Agent

- Uso de recursos del Agent

- Logs correlacionados

- Stacks tecnológicos de llamada en profundidad PHP 5

- Herramienta de diagnóstico de .NET

- Cuantificación de APM

- Go Compile-Time Instrumentation

- Logs de inicio del rastreador

- Logs de depuración del rastreador

- Errores de conexión

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Setting Up Amazon DocumentDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Exploring Database Schemas

- Exploring Recommendations

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Experiencia digital

- Real User Monitoring

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Análisis de productos

- Entrega de software

- CI Visibility

- CD Visibility

- Deployment Gates

- Test Visibility

- Configuración

- Network Settings

- Tests en contenedores

- Repositories

- Explorador

- Monitores

- Test Health

- Flaky Test Management

- Working with Flaky Tests

- Test Impact Analysis

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Code Coverage

- Quality Gates

- Métricas de DORA

- Feature Flags

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Code Security

- Cloud Security Management

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- CloudPrem

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Ayuda

(LEGACY) Prevención de la pérdida de datos

Este producto no es compatible con el sitio Datadog seleccionado. ().

Esta guía es para despliegues a nivel de producción a gran escala.

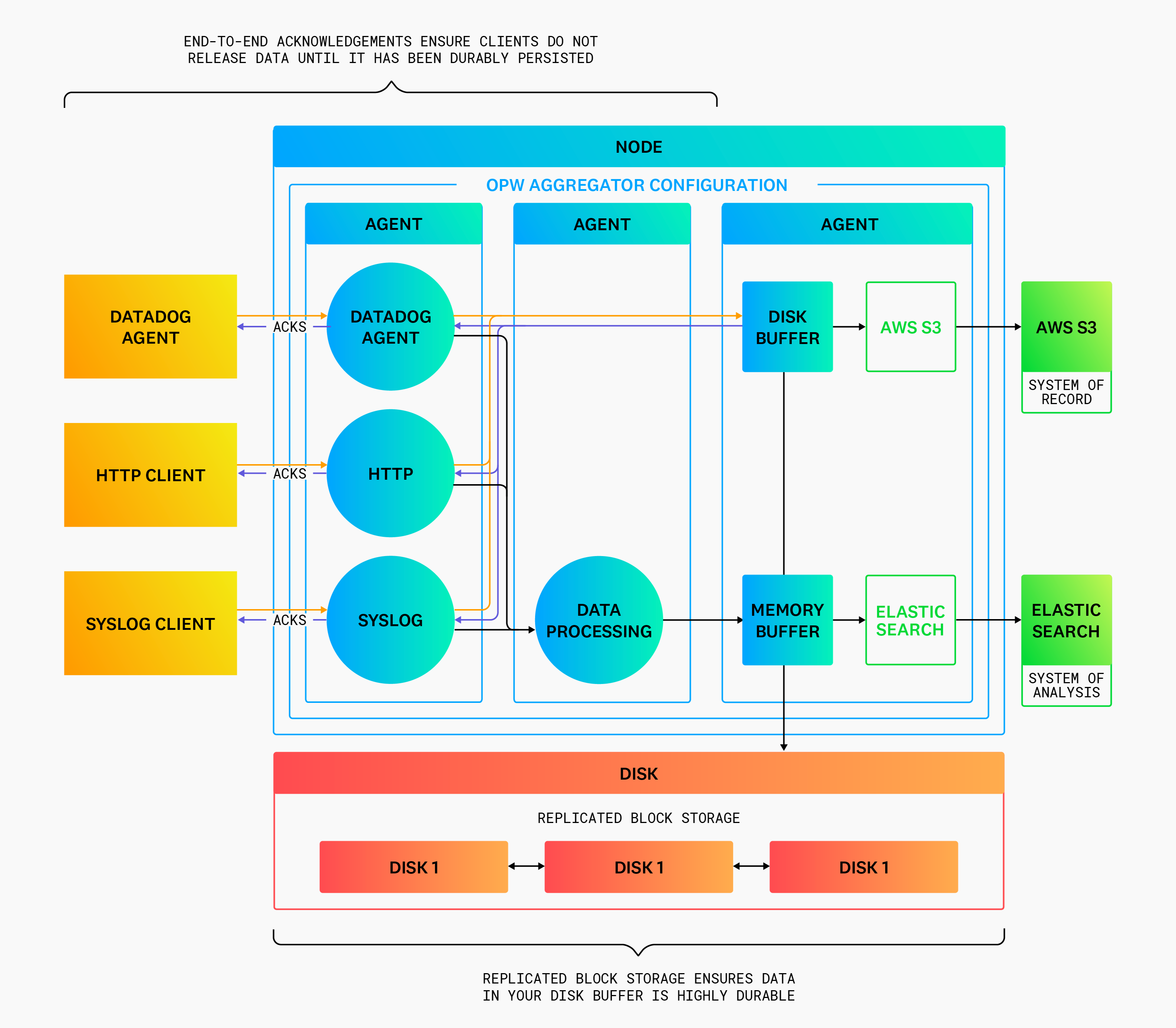

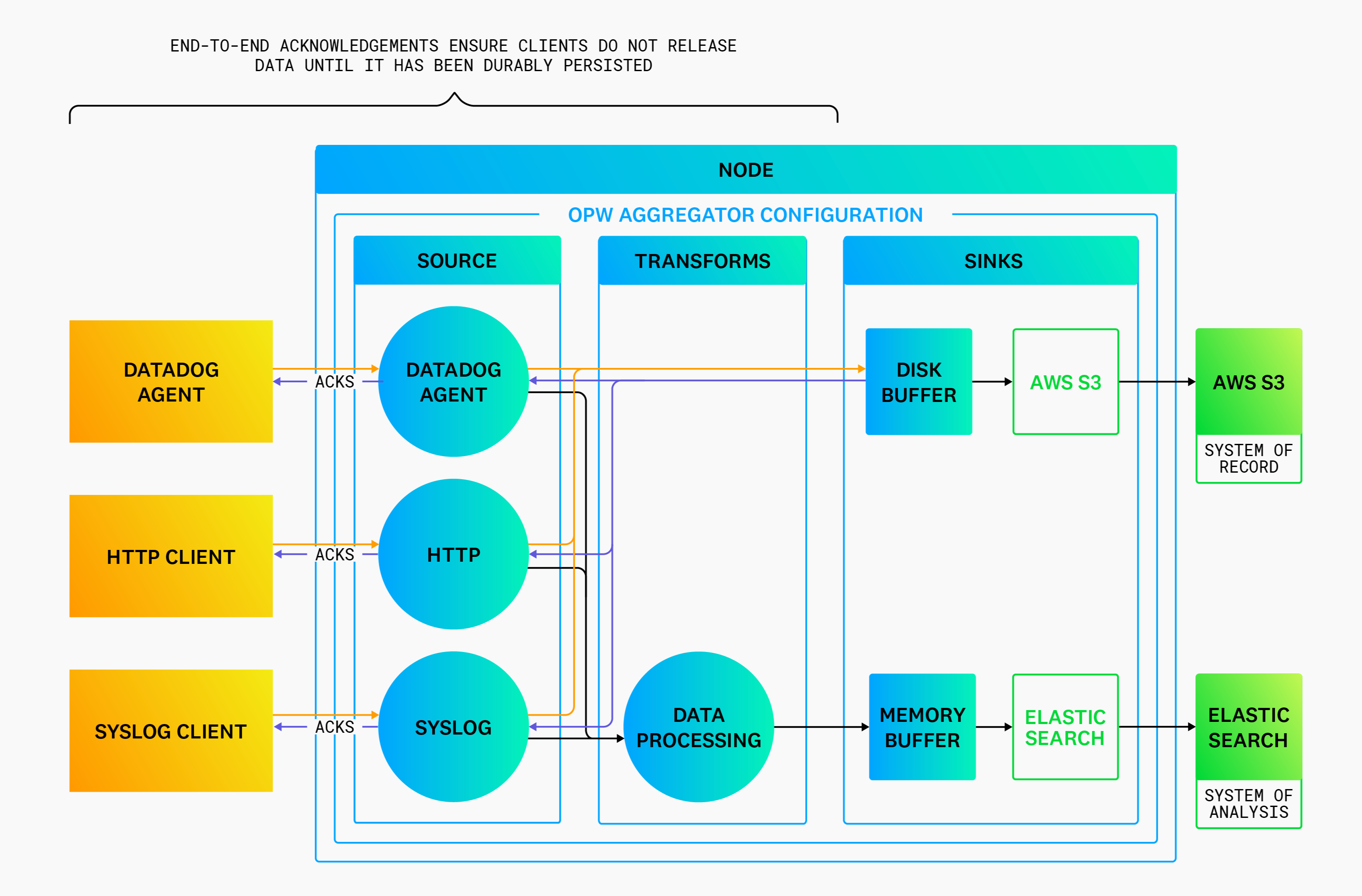

Alta durabilidad

La alta durabilidad es la capacidad de conservar los datos cuando se producen errores en el sistema. La arquitectura del agregador está diseñada para asumir la responsabilidad de la alta durabilidad. Esto simplifica tu estrategia de durabilidad al desplazar la carga de tus Agents y localizarla en tus agregadores. Además, este enfoque concentrado permite estrategias de durabilidad que serían difíciles de implementar en todos los nodos de Agent.

Para lograr una alta durabilidad:

Configura tus Agents para que sean simples forwarders de datos y transmitan los datos directamente a tu agregador del Observability Pipelines Worker. Esto reduce la cantidad de tiempo que tus datos están expuestos a pérdidas en la periferia, ya que aún no son redundantes.

Elige un destino altamente duradero que sirva como sistema de registro (por ejemplo, Amazon S3). Este sistema es responsable de la durabilidad de los datos en reposo y suele denominarse archivos o lagos de datos.

Por último, configura los sinks del Observability Pipelines Worker que escriben datos en tu sistema de registro para activar los reconocimientos de extremo a extremo y los buffers de disco. Por ejemplo:

sinks:

aws_s3:

acknowledgments: true

buffer:

type: "disk"

Directrices para la prevención de la pérdida de datos

Uso del reconocimiento de extremo a extremo

Un problema con el proceso del sistema operativo del Observability Pipelines Worker podría suponer un riesgo de pérdida de datos almacenados en memoria durante el tiempo del problema. Activa la característica de reconocimiento de extremo a extremo del Observability Pipelines Worker para mitigar el riesgo de pérdida de datos:

sinks:

aws_s3:

acknowledgments: true

Con esta característica activada, el Observability Pipelines Worker no responde a los Agents hasta que los datos hayan persistido de forma duradera. Esto evita que el Agent libere los datos antes de los esperado y los envíe de nuevo si no se ha recibido un reconocimiento.

Gestión de errores en los nodos

Los errores en los nodos se refieren al error completo de un nodo individual. También se pueden tratar mediante reconocimientos de extremo a extremo. Consulta Uso del reconocimiento de extremo a extremo para ver más detalles.

Gestión de errores en el disco

Los errores en el disco se refieren al error de un disco individual. La pérdida de datos relacionada con los errores en el disco se puede mitigar mediante un sistema de archivos de alta durabilidad en el que los datos se repliquen en varios discos, como el almacenamiento en bloques (por ejemplo, Amazon EBS).

Gestión de errores en el procesamiento de los datos

El Observability Pipelines Worker puede tener problemas, como no poder analizar un log, al intentar procesar datos malformados. Hay dos maneras de mitigar este problema:

Archivado directo: dirige los datos directamente desde tus fuentes a tu archivo. Esto garantiza que los datos lleguen a tu archivo sin riesgo de eliminación. Además, estos datos pueden volver a reproducirse una vez corregido el error de procesamiento.

Enrutamiento de eventos con errores: el Observability Pipelines Worker ofrece el enrutamiento de eventos con errores para usuarios que deseen archivar datos procesados, como datos estructurados y enriquecidos. Ciertas transformaciones del Observability Pipelines Worker vienen con una salida abandonada que puede conectarse a un sink para su durabilidad y reproducción.

¿Cuál es la mejor estrategia?

Si la durabilidad es el criterio más importante, utiliza el método de archivado directo, ya que aborda los casos de pérdida de datos. Utiliza el método de enrutamiento de eventos con errores, también conocido como lago de datos, si prefieres analizar los datos en tu archivo. Esto tiene la ventaja de utilizar tu archivo o lago de datos para análisis a largo plazo. Los archivos de logs de Datadog y Amazon Athena son ejemplos de soluciones de almacenamiento de archivos.

Gestión de errores en el destino

Los errores en el destino se refieren al error total de un destino descendente (por ejemplo, Elasticsearch). La pérdida de datos se puede mitigar en caso de problemas con el destino descendente mediante el uso de buffers de disco lo suficientemente grandes como para soportar el tiempo de interrupción. Esto permite que los datos permanezcan en buffer mientras el servicio está inactivo y se vacíen cuando el servicio vuelva a funcionar. Por este motivo, se recomiendan los buffers de disco lo suficientemente grandes como para contener al menos una hora de datos. Consulta Optimización de la instancia para ver más detalles.