- 重要な情報

- はじめに

- 用語集

- Standard Attributes

- ガイド

- インテグレーション

- エージェント

- OpenTelemetry

- 開発者

- Administrator's Guide

- API

- Partners

- DDSQL Reference

- モバイルアプリケーション

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- アプリ内

- ダッシュボード

- ノートブック

- DDSQL Editor

- Reference Tables

- Sheets

- Watchdog

- アラート設定

- メトリクス

- Bits AI

- Internal Developer Portal

- Error Tracking

- Change Tracking

- Service Management

- Actions & Remediations

- インフラストラクチャー

- Cloudcraft

- Resource Catalog

- ユニバーサル サービス モニタリング

- Hosts

- コンテナ

- Processes

- サーバーレス

- ネットワークモニタリング

- Cloud Cost

- アプリケーションパフォーマンス

- APM

- Continuous Profiler

- データベース モニタリング

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Digital Experience

- RUM & セッションリプレイ

- Synthetic モニタリング

- Continuous Testing

- Product Analytics

- Software Delivery

- CI Visibility (CI/CDの可視化)

- CD Visibility

- Deployment Gates

- Test Visibility

- Code Coverage

- Quality Gates

- DORA Metrics

- Feature Flags

- セキュリティ

- セキュリティの概要

- Cloud SIEM

- Code Security

- クラウド セキュリティ マネジメント

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- AI Observability

- ログ管理

- Observability Pipelines(観測データの制御)

- ログ管理

- CloudPrem

- 管理

LLM Observability

This product is not supported for your selected Datadog site. ().

概要

LLM Observability を使用すると、チャットボットなどの LLM 対応アプリケーションを監視、トラブルシューティング、および評価できます。これにより、問題の根本原因を特定し、運用パフォーマンスを監視し、LLM アプリケーションの品質・プライバシー・安全性を評価することが可能です。

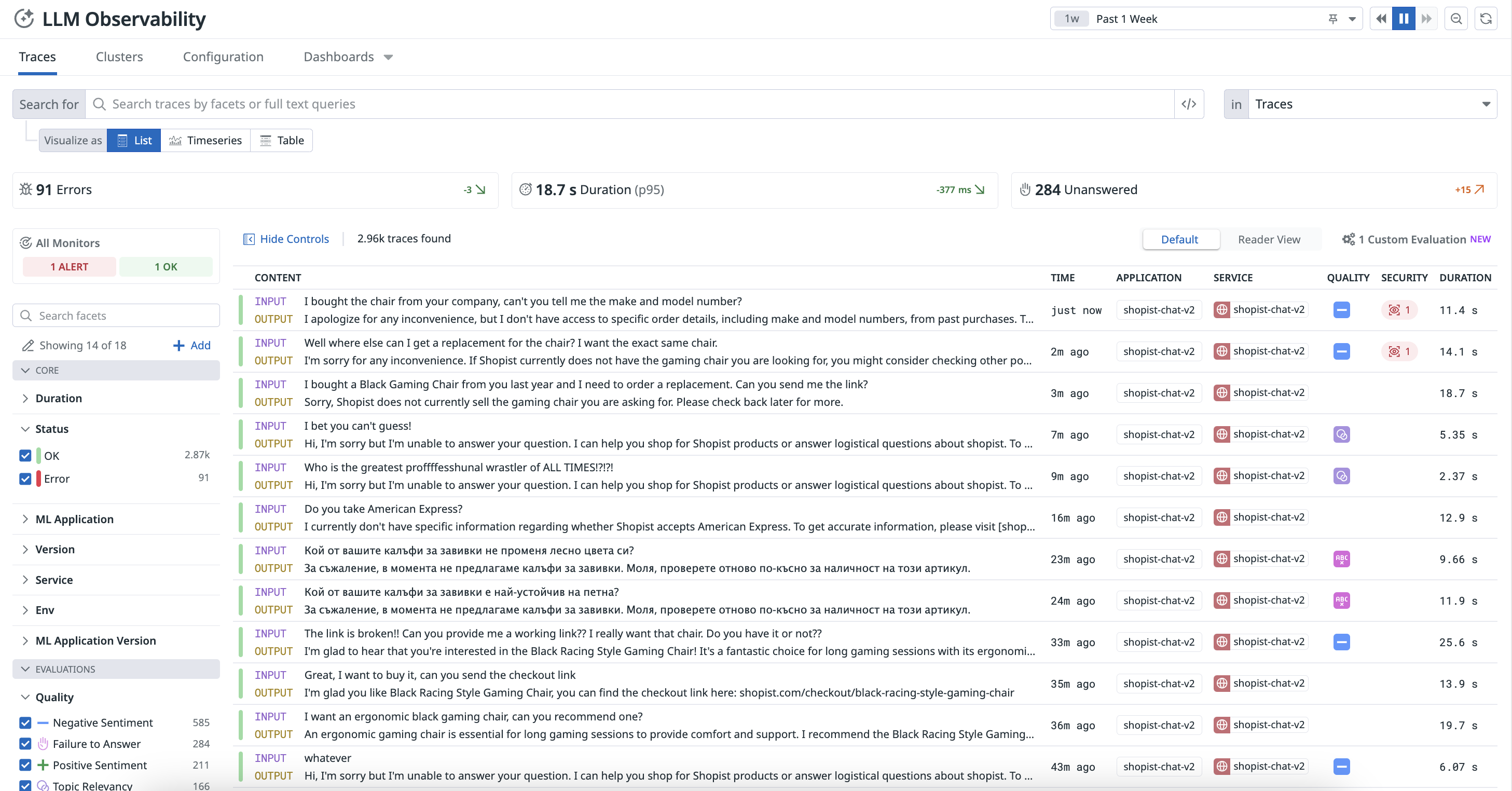

アプリケーションが処理した各リクエストは、Datadog の LLM Observability ページにトレースとして表示されます。

トレースは以下のような要素を表せます。

- トークン、エラー情報、レイテンシーを含む個々の LLM 推論

- LLM コールやツールコール、前処理ステップなどを含む、あらかじめ定義された LLM ワークフロー

- LLM エージェントによって実行される動的な LLM ワークフロー

各トレースには、エージェントが下した選択や特定のワークフロー内の各ステップを表すスパンが含まれます。また、入力および出力、レイテンシー、プライバシー上の懸念点、エラーなどの情報が含まれる場合もあります。詳細は用語と概念を参照してください。

エンドツーエンドトレーシングによるトラブルシューティング

LLM アプリケーション内のあらゆるチェーンやコールを可視化し、問題のあるリクエストを特定してエラーの根本原因を突き止めることができます。

運用メトリクスの監視とコスト最適化

すぐに使えるダッシュボードを用いて、すべての LLM アプリケーションにおけるコスト、レイテンシー、パフォーマンス、使用状況の傾向を監視できます。

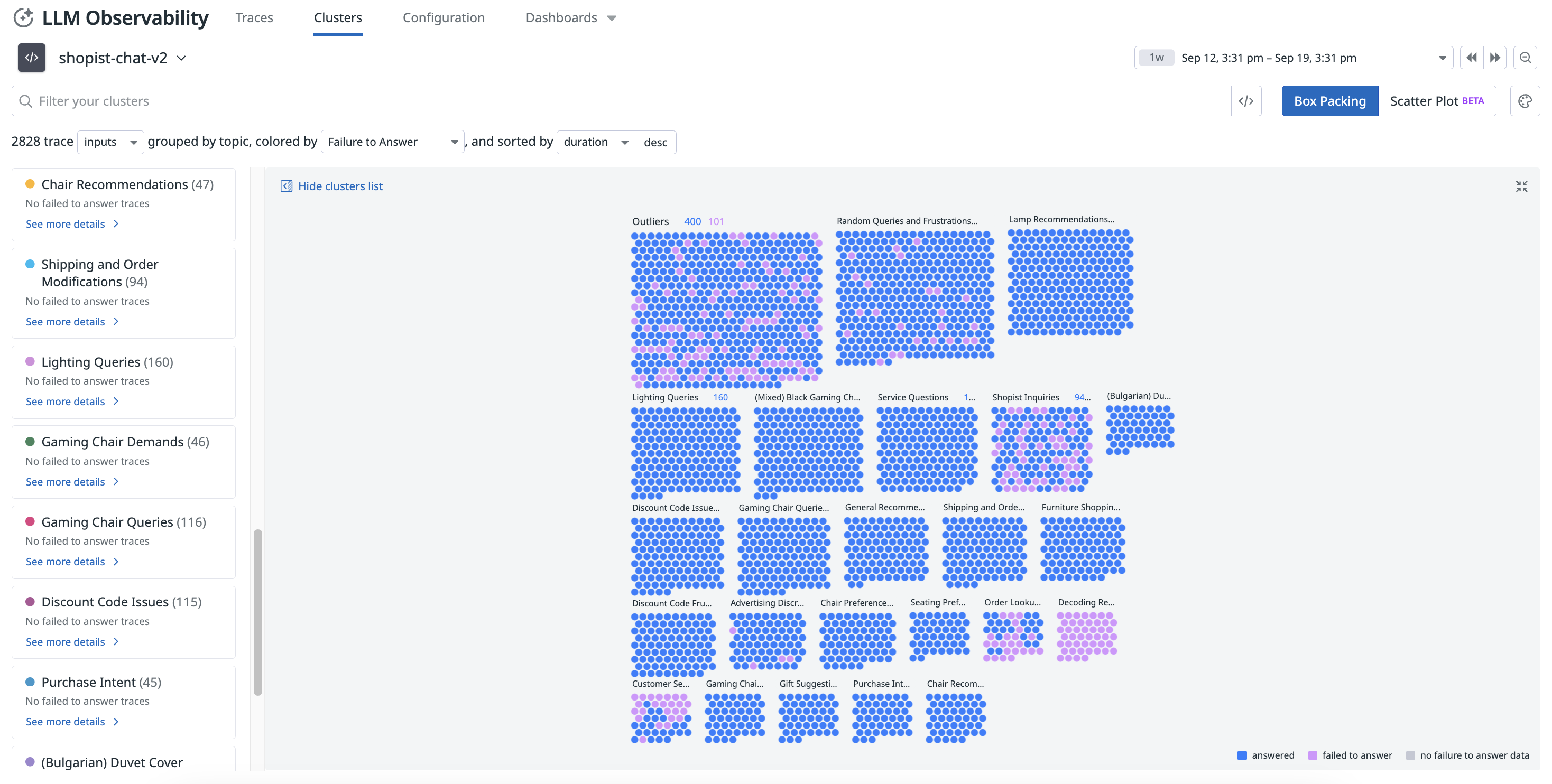

LLM アプリケーションの品質と有効性の評価

トピック別のクラスタリングや感情分析、回答不能チェックなどの手法を用いて、問題のあるクラスターを特定し、時間経過によるレスポンス品質を追跡できます。

機密データの保護と悪意あるユーザーの特定

AI アプリケーション内で機密データを自動的にスキャンおよびマスキングし、プロンプトインジェクションなどの潜在的脅威を特定できます。

LLM Observability とのインテグレーション活用

LLM Observability SDK for Python は、OpenAI、LangChain、AWS Bedrock、Anthropic などのフレームワークと統合できます。コード変更不要で、LLM コールを自動的にトレースし、レイテンシー、エラー、トークン使用状況などのメトリクスを取得できます。

Datadog では、AI および ML に関するさまざまな機能を提供しています。Integrations ページおよび Datadog Marketplace 上の AI/ML インテグレーションは、Datadog 全体で利用できる機能です。

例えば、APM は OpenAI の利用状況を監視するためのネイティブインテグレーションを提供し、Infrastructure Monitoring は NVIDIA DCGM Exporter と統合して計算集約的な AI ワークロードを監視します。これらは LLM Observability が提供する機能とは異なります。

例えば、APM は OpenAI の利用状況を監視するためのネイティブインテグレーションを提供し、Infrastructure Monitoring は NVIDIA DCGM Exporter と統合して計算集約的な AI ワークロードを監視します。これらは LLM Observability が提供する機能とは異なります。

詳細については、自動インスツルメンテーションのドキュメントを参照してください。

準備はいいですか?

セットアップドキュメントを参照して LLM アプリケーションへのインスツルメンテーション手順を確認するか、LLM アプリケーションのトレースガイドに従って LLM Observability SDK for Python を使用してトレースを生成してください。