- 重要な情報

- はじめに

- Datadog

- Datadog サイト

- DevSecOps

- AWS Lambda のサーバーレス

- エージェント

- インテグレーション

- コンテナ

- ダッシュボード

- アラート設定

- ログ管理

- トレーシング

- プロファイラー

- タグ

- API

- Service Catalog

- Session Replay

- Continuous Testing

- Synthetic モニタリング

- Incident Management

- Database Monitoring

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Code Analysis

- Learning Center

- Support

- 用語集

- Standard Attributes

- ガイド

- インテグレーション

- エージェント

- OpenTelemetry

- 開発者

- 認可

- DogStatsD

- カスタムチェック

- インテグレーション

- Create an Agent-based Integration

- Create an API Integration

- Create a Log Pipeline

- Integration Assets Reference

- Build a Marketplace Offering

- Create a Tile

- Create an Integration Dashboard

- Create a Recommended Monitor

- Create a Cloud SIEM Detection Rule

- OAuth for Integrations

- Install Agent Integration Developer Tool

- サービスのチェック

- IDE インテグレーション

- コミュニティ

- ガイド

- Administrator's Guide

- API

- モバイルアプリケーション

- CoScreen

- Cloudcraft

- アプリ内

- Service Management

- インフラストラクチャー

- アプリケーションパフォーマンス

- APM

- Continuous Profiler

- データベース モニタリング

- Data Streams Monitoring

- Data Jobs Monitoring

- Digital Experience

- Software Delivery

- CI Visibility (CI/CDの可視化)

- CD Visibility

- Test Visibility

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- DORA Metrics

- セキュリティ

- セキュリティの概要

- Cloud SIEM

- クラウド セキュリティ マネジメント

- Application Security Management

- AI Observability

- ログ管理

- Observability Pipelines(観測データの制御)

- ログ管理

- 管理

Google Cloud Platform

概要

Google Cloud Platform に接続して、すべての Google Compute Engine (GCE) ホストを Datadog に表示できます。GCE ホストタグと追加した GCE ラベルがホストに自動的にタグ付けされるため、Datadog のインフラストラクチャー概要にホストを表示し、分類することができます。

Datadog の GCP インテグレーションは、すべての Google Cloud メトリクスを収集するように構築されています。Datadog では継続的にドキュメントを更新してすべてのサブインテグレーションを表示できるように努めていますが、新しいメトリクスやサービスがクラウドサービスから次々にリリースされるため、インテグレーション一覧が追い付かないことがあります。

| インテグレーション | 説明 |

|---|---|

| App Engine | スケーラブルなアプリケーションを構築できる PaaS (サービスとしてのプラットフォーム) |

| Big Query | 企業向けデータウェアハウス |

| Bigtable | NoSQL ビッグデータデータベースサービス |

| Cloud SQL | MySQL データベースサービス |

| Cloud APIs | すべての Google Cloud Platform サービス向けのプログラムインターフェイス |

| Cloud Armor | DoS 攻撃や Web 攻撃から保護するネットワークセキュリティサービス |

| Cloud Composer | フルマネージド型のワークフローオーケストレーションサービス |

| Cloud Dataproc | Apache Spark と Apache Hadoop のクラスターを実行するためのクラウドサービス |

| Cloud Dataflow | ストリームおよびバッチモードでデータを変換し、リッチ化するためのフルマネージドサービス |

| Cloud Filestore | 高パフォーマンスのフルマネージド型ファイルストレージ |

| Cloud Firestore | モバイル、Web、およびサーバー開発向けの柔軟でスケーラブルなデータベース |

| Cloud Interconnect | ハイブリッド接続 |

| Cloud IoT | セキュリティ保護されたデバイス接続および管理 |

| Cloud Load Balancing | 負荷分散型コンピューティングリソースの分配 |

| Cloud Logging | リアルタイムのログ管理および分析 |

| Cloud Memorystore for Redis | フルマネージド型のインメモリデータストアサービス |

| Cloud Router | BGP を使用して、VPC とオンプレミスネットワークとの間でルートを交換 |

| Cloud Run | HTTP 経由でステートレスコンテナを実行するマネージド型のコンピューティングプラットフォーム |

| Cloud Security Command Center | Security Command Center は脅威レポートサービスです。 |

| Cloud Tasks | 分散型タスクキュー |

| Cloud TPU | 機械学習モデルのトレーニングと実行 |

| Compute Engine | 高パフォーマンスの仮想マシン |

| Container Engine | Google が管理する Kubernetes |

| Datastore | NoSQL データベース |

| Firebase | アプリケーション開発用のモバイルプラットフォーム |

| Functions | イベントベースのマイクロサービスを構築するためのサーバーレスプラットフォーム |

| Kubernetes Engine | クラスターマネージャーとオーケストレーションシステム |

| Machine Learning | 機械学習サービス |

| Private Service Connect | プライベート VPC 接続でマネージドサービスにアクセスする |

| Pub/Sub | リアルタイムメッセージングサービス |

| Spanner | 水平方向に拡張可能でグローバルな一貫性を持つリレーショナルデータベースサービス |

| Storage | 統合型オブジェクトストレージ |

| Vertex AI | カスタムの機械学習 (ML) モデルの構築、トレーニング、デプロイを行います。 |

| VPN | マネージド型のネットワーク機能 |

セットアップ

Datadog の Google Cloud インテグレーションをセットアップして、Google Cloud サービスからメトリクスとログを収集します。

前提条件

組織でドメインによるアイデンティティを制限している場合、Datadog の顧客アイデンティティをポリシーで許可値として追加する必要があります。Datadog の顧客アイデンティティ:

C0147pk0iサービスアカウントのなりすましとプロジェクトの自動検出は、プロジェクト監視のために特定のロールと API が有効化されていることを前提としています。開始する前に、監視するプロジェクトで以下の API が有効になっていることを確認してください。

- Cloud Resource Manager API

- Google Cloud Billing API

- Cloud Monitoring API

- Compute Engine API

- Cloud Asset API

- IAM API

- 監視対象のプロジェクトが、他の複数のプロジェクトからメトリクスを取り込むスコーピングプロジェクトとして構成されていないことを確認してください。

メトリクスの収集

インストール

サイトの Datadog Google Cloud インテグレーションは、サービスアカウントを使用して、Google Cloud と Datadog 間の API 接続を作成します。以下の手順に従って、サービスアカウントを作成し、Datadog にサービスアカウントの資格情報を提供することで、API 呼び出しを自動化します。

サービスアカウントのなりすまし は サイトでは利用できません。

注: Google Cloud 請求、Cloud Monitoring API、Compute Engine API、Cloud Asset API は、監視したいすべてのプロジェクトで有効にしておく必要があります。

Datadog とインテグレーションしたい Google Cloud プロジェクトの Google Cloud 資格情報ページに移動します。

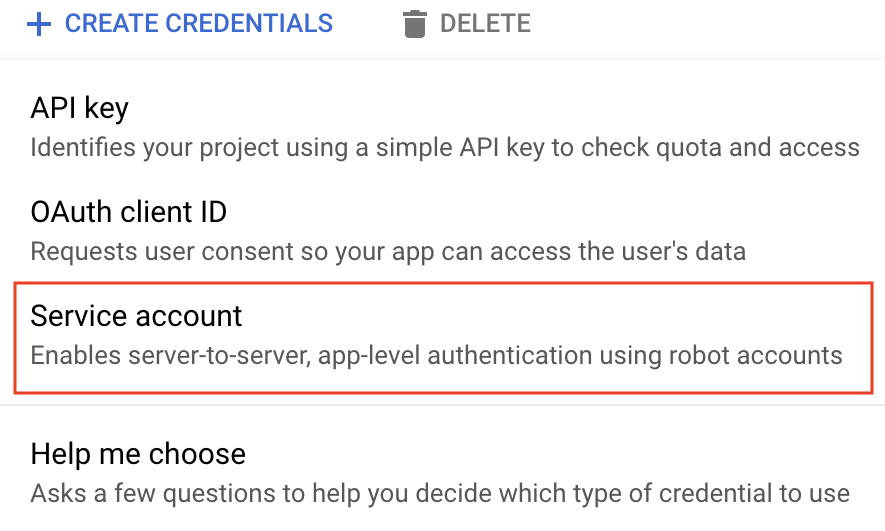

Create credentials (資格情報の作成) をクリックします。

Service account (サービスアカウント) を選択します。

サービスアカウントに一意の名前とオプションの説明を付けます。

Create and continue (作成して続行) をクリックします。

以下のロールを追加します。

- コンピュートビューア

- モニタリングビューア

- クラウドアセットビューア

Done をクリックします。 注: Compute Engine と Cloud Asset のロールを選択するには、Service Account Key Admin である必要があります。選択したロールはすべて、Datadog があなたに代わってメトリクス、タグ、イベント、ユーザーラベルを収集できるようにします。

ページの下部で、サービスアカウントを見つけて、今作成したものを選択します。

Add Key -> Create new key (キーを追加 -> 新しいキーを作成) をクリックし、タイプとして JSON を選択します。

Create (作成) をクリックします。JSON キーファイルがコンピュータにダウンロードされます。このファイルは、インストールを完了するために必要ですので、保存場所に注意してください。

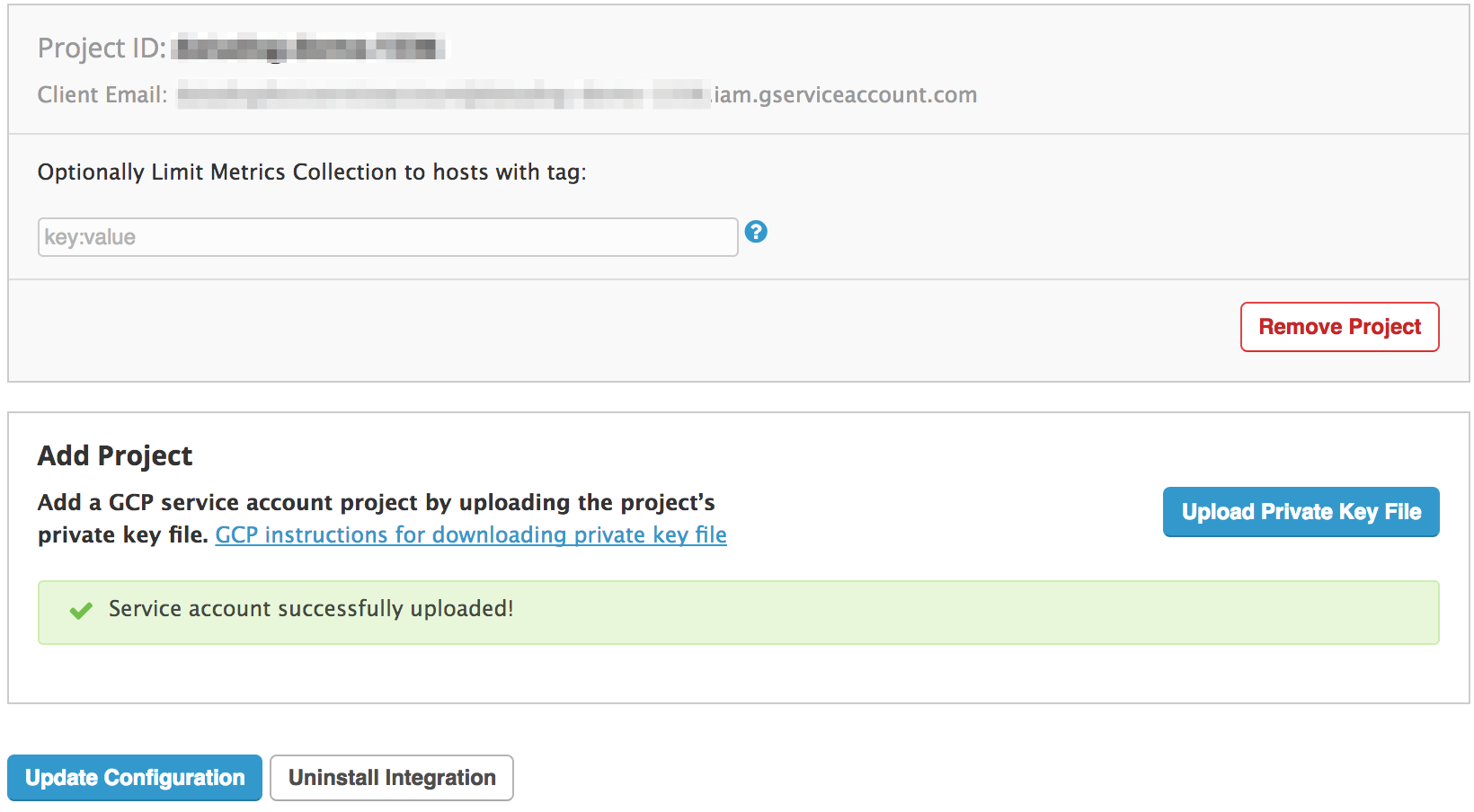

Configuration (構成) タブで、Upload Key File (キーファイルのアップロード) を選択して、このプロジェクトを Datadog とインテグレーションします。

オプションで、タグを使用して、このインテグレーションからホストを除外することができます。これに関する詳しい説明は 構成セクションにあります。

Install/Update (インストール/更新) をクリックします。

複数のプロジェクトを監視する場合は、次の方法のいずれかを使用します。

- 複数のサービスアカウントを使用する場合は、上のプロセスを繰り返します。

- 手順 10 でダウンロードした JSON ファイルの

project_idを更新して、同じサービスアカウントを使用します。その後、手順 11-14 で説明したように、ファイルを Datadog にアップロードします。

構成

オプションで、特定のプロジェクトのドロップダウンメニューの下にある Limit Metric Collection テキストボックスにタグを入力することで、Datadog にプルされる GCE インスタンスを制限できます。定義されたタグのいずれかに一致するホストだけが Datadog にインポートされます。複数のホストに一致するワイルドカード (1 文字の場合は ?、複数文字の場合は *)、または特定のホストを除外する ! を使用できます。次の例では、c1* サイズのインスタンスは含まれますが、ステージングホストは除外されます。

datadog:monitored,env:production,!env:staging,instance-type:c1.*

詳細は Google のドキュメントのラベルの作成と管理を参照してください。

サービスアカウントのなりすましとプロジェクトの自動発見を使用して、Datadog と Google Cloud を統合することができます。

この方法では、関連するプロジェクトに IAM ロールを割り当てることで、サービスアカウントから見えるすべてのプロジェクトを監視することができます。これらのロールを個別にプロジェクトに割り当てることもできますし、組織レベルやフォルダレベルでこれらのロールを割り当てて、プロジェクトのグループを監視するように Datadog を構成することもできます。このようにロールを割り当てることで、Datadog は、指定されたスコープ内のすべてのプロジェクト (将来的にそのグループに追加される新しいプロジェクトも含む) を自動的に発見・監視することができます。

1. Google Cloud サービスのアカウントを作成する

- Google Cloud コンソールを開きます。

- IAM & Admin > Service Accounts に移動します。

- 上部の Create service account をクリックします。

- サービスアカウントに一意の名前を付け、それから Create and continue をクリックします。

- サービスアカウントに以下のロールを追加します。

- Monitoring Viewer

- Compute Viewer

- Cloud Asset Viewer

- Browser

- Continue、Done の順にクリックすると、サービスアカウントの作成が完了します。

2. サービスアカウントに Datadog プリンシパルを追加する

Datadog の Integrations > Google Cloud Platform に移動します。

Add GCP Account をクリックします。構成されたプロジェクトがない場合、自動的にこのページにリダイレクトされます。

Datadog プリンシパルを生成していない場合は、Generate Principal ボタンをクリックします。

Datadog プリンシパルをコピーして、次のセクションのために保管しておきます。

[次のセクション](#3-complete-the-integration-setup-in-datadog)では、このウィンドウを開いたままにしておきます。Google Cloud コンソール の Service Accounts (サービスアカウント) メニューで、最初のセクションで作成したサービスアカウントを探します。

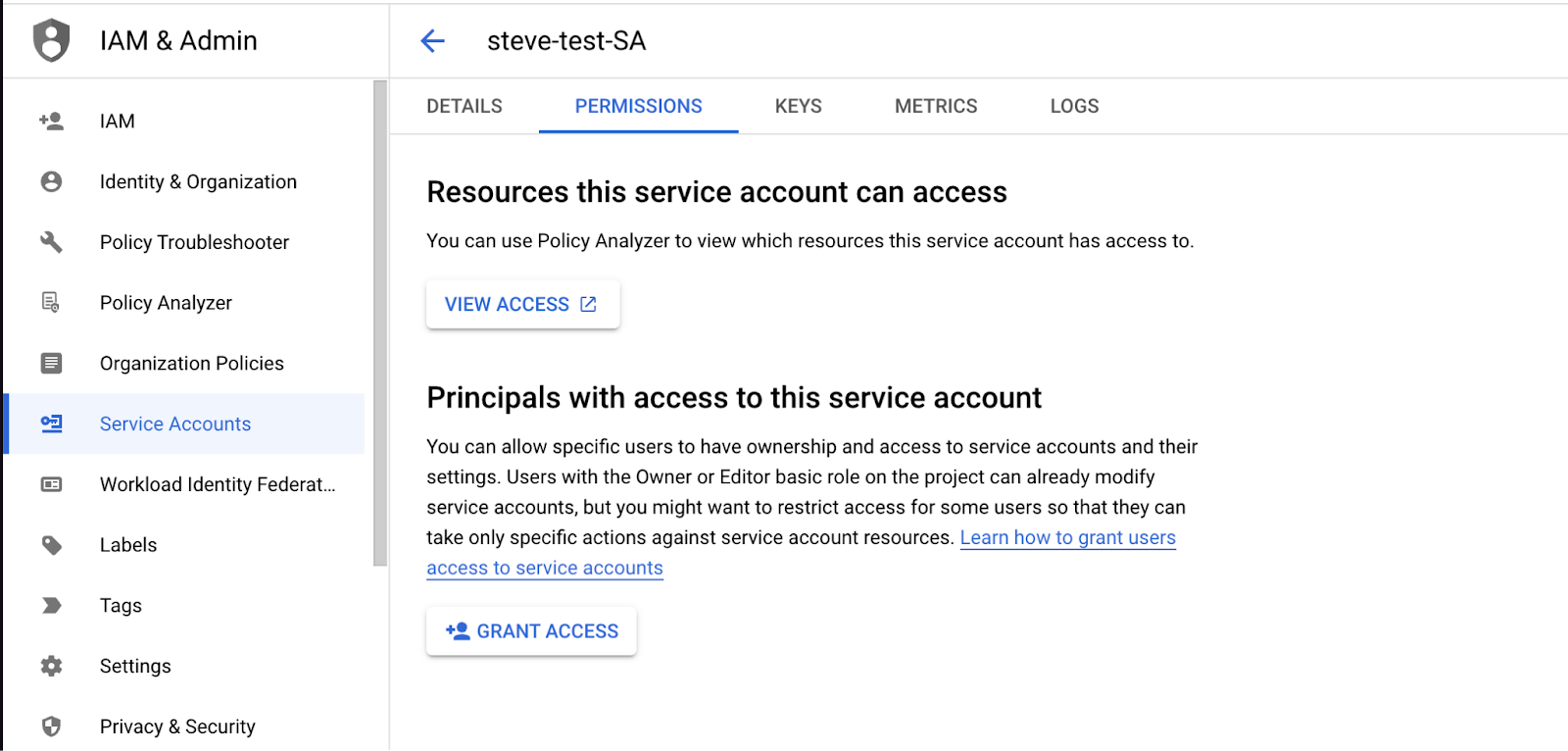

Permissions タブを開き、Grant Access をクリックします。

Datadog プリンシパルを New principals テキストボックスに貼り付けます。

Service Account Token Creator のロールを割り当て、Save をクリックします。

注: 以前に Datadog の共有プリンシパルを使用してアクセスを構成した場合、これらの手順を完了した後、そのプリンシパルの権限を取り消すことができます。

3. Datadog でインテグレーション設定を完了する

- Google Cloud コンソールで、Service Account > Details タブに移動します。そこには、この Google サービスアカウントに関連するメールが記載されています。これは、

<sa-name>@<project-id>.iam.gserviceaccount.comに似ています。 - このメールをコピーします。

- Datadog のインテグレーション構成タイル (前セクションで Datadog プリンシパルをコピーしたところ) に戻ります。

- Add Service Account Email の下にあるボックスに、以前コピーしたメールを貼り付けます。

- Verify and Save Account をクリックします。

約 15 分で、Datadog にメトリクスが表示されます。

4. 他のプロジェクトにロールを割り当てる (オプション)

プロジェクトの自動発見により、監視対象のプロジェクトを追加するプロセスが簡素化されます。サービスアカウントに他のプロジェクト、フォルダ、または組織へのアクセスを許可すると、Datadog はこれらのプロジェクト (およびフォルダや組織にネストされたプロジェクト) を発見し、インテグレーションタイルに自動的に追加します。

- 希望するスコープでロールを割り当てるための適切な権限があることを確認してください。

- Project IAM Admin (またはそれ以上)

- Folder Admin

- Organization Admin

- Google Cloud コンソールで、IAM ページに移動します。

- プロジェクト、フォルダ、または組織を選択します。

- リソースに対して他のロールをまだ持っていないプリンシパルにロールを付与するには、Grant Access をクリックし、前に作成したサービスアカウントのメールを入力します。

- 以下のロールを割り当てます。

- コンピュートビューア

- モニタリングビューア

- クラウドアセットビューア 注: Browser ロールは、サービスアカウントのデフォルトプロジェクトでのみ必要です。

- Save をクリックします。

構成

オプションとして、特定のプロジェクトのドロップダウンメニューの下にある Limit Metric Collection (メトリクス収集の制限) テキストボックスにタグを入力することで、Datadog に取り込む GCE インスタンスを制限することができます。定義されたタグに一致するホストのみが Datadog にインポートされます。ワイルドカード (? は 1 文字、* は複数文字) を使って多くのホストにマッチさせたり、! を使って特定のホストを除外することができます。この例では、すべての c1* サイズのインスタンスを含めますが、ステージングホストは除外します。

datadog:monitored,env:production,!env:staging,instance-type:c1.*

詳細については、ラベルの作成と管理に関する Google のドキュメントを参照してください。

ログ収集

Google Cloud Dataflow と Datadog テンプレートを使用して、Google Cloud サービスからのログを Datadog に転送します。この方法では、Datadog に転送する前にイベントの圧縮とバッチ処理の両方が可能です。このセクションの指示に従って、以下を行います。

1。Pub/Sub トピックとプルサブスクリプションを作成し、構成されたログシンクからログを受信します。 2。カスタム Dataflow ワーカーサービスアカウントを作成し、Dataflow パイプラインワーカーに最小権限を提供します。 3。ログシンクを作成し、Pub/Sub トピックにログを公開します。 4。Datadog テンプレートを使用して Dataflow ジョブを作成し、Pub/Sub サブスクリプションから Datadog にログをストリーミングします。

GCE や GKE ログを含め、ログシンクで作成したロギングフィルターを通して、どのログを Datadog に送信するかを完全に制御することができます。フィルターの書き方については、Google のロギングクエリ言語ページを参照してください。

注: Google Cloud Dataflow を使用するには、Dataflow API を有効にする必要があります。詳細は Google Cloud ドキュメントの API の有効化を参照してください。

GCE または GKE で実行されているアプリケーションからログを収集するには、Datadog Agent を使用することもできます。

Pub/Sub Push サブスクリプションを使用した Google Cloud のログ収集は、以下の理由で非推奨となっています。

- Google Cloud VPC を使用している場合、新しい Push サブスクリプションを外部エンドポイントで構成することができない (詳細については、Google Cloud のサポートされる製品と制限ページを参照してください)

- Push サブスクリプションは、イベントの圧縮やバッチ処理を提供しないため、非常に少ないログ量にのみ適している

Push サブスクリプションのドキュメントは、トラブルシューティングやレガシーセットアップの変更のためにのみ維持されます。代わりに Datadog Dataflow テンプレートで Pull サブスクリプションを使用して、Google Cloud ログを Datadog に転送してください。

1. Cloud Pub/Sub トピックとサブスクリプションを作成する

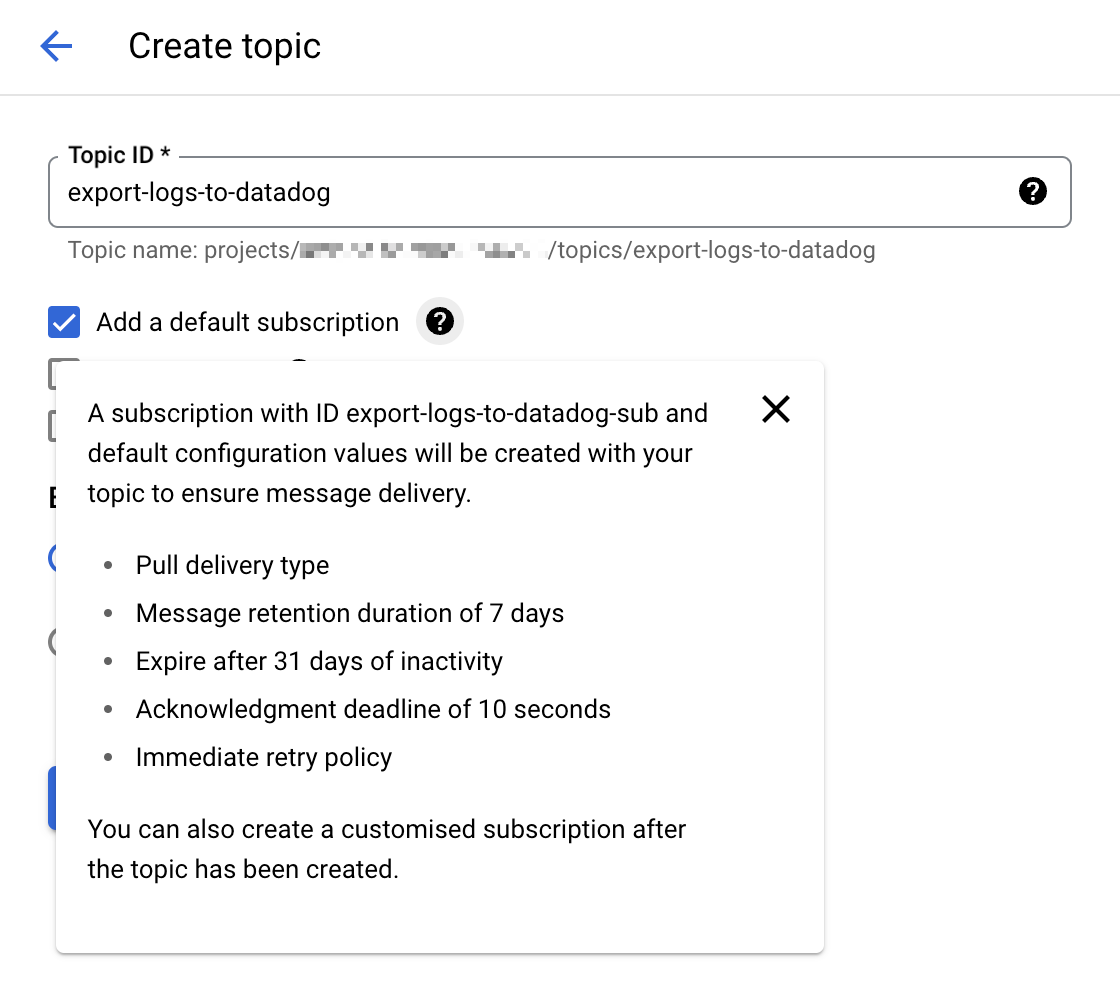

Cloud Pub/Sub コンソールに移動し、新しいトピックを作成します。 Add a default subscription (デフォルトのサブスクリプションを追加する) オプションを選択して、セットアップを簡素化します。

注: 手動で Cloud Pub/Sub サブスクリプションを Pull 配信タイプで構成することもできます。手動で Pub/Sub サブスクリプションを作成する場合は、

Enable dead lettering(デッドレタリングを有効にする) ボックスのチェックを外したままにしてください。詳細については、サポートされていない Pub/Sub 機能を参照してください。

トピックに

export-logs-to-datadogのような明示的な名前を付け、Create をクリックします。Datadog API によって拒否されたログメッセージを処理するために、追加のトピックとデフォルトのサブスクリプションを作成します。このトピックの名前は、Datadog Dataflow テンプレート内で

outputDeadletterTopicテンプレートパラメーターのパス構成の一部として使用されます。失敗したメッセージの問題を検査して修正したら、Pub/Sub to Pub/Sub テンプレートジョブを実行して元のexport-logs-to-datadogトピックに送り返します。Datadog では、Secret Manager で有効な Datadog API キーの値でシークレットを作成し、後で Datadog Dataflow テンプレートで使用することを推奨しています。

警告: クラウド Pub/Sub は Google Cloud のクォータと制限の対象となります。ログの数がこれらの制限を超える場合、Datadog はログを複数のトピックに分割することを推奨します。これらの制限に近づいた場合のモニター通知のセットアップについては、Pub/Sub ログ転送の監視のセクションを参照してください。

2. カスタム Dataflow ワーカーサービスアカウントを作成する

Dataflow パイプラインワーカーのデフォルトの動作は、プロジェクトの Compute Engine のデフォルトのサービスアカウントを使用することです。このアカウントは、プロジェクト内のすべてのリソースへの権限を付与します。Production 環境からログを転送している場合は、代わりに必要なロールと権限のみを持つカスタムワーカーのサービスアカウントを作成し、このサービスアカウントを Dataflow パイプラインワーカーに割り当てる必要があります。

- Google Cloud コンソールの Service Accounts ページにアクセスし、プロジェクトを選択します。

- CREATE SERVICE ACCOUNT をクリックし、サービスアカウントに分かりやすい名前を付けます。CREATE AND CONTINUE をクリックします。

- 必要な権限テーブルにロールを追加し、DONE をクリックします。

必要なアクセス許可

- Dataflow Admin

roles/dataflow.admin

このサービスアカウントが Dataflow の管理者タスクを実行することを許可します。- Dataflow Worker

roles/dataflow.worker

このサービスアカウントが Dataflow のジョブオペレーションを実行することを許可します。- Pub/Sub Viewer

roles/pubsub.viewer

このサービスアカウントが Google Cloud ログで Pub/Sub サブスクリプションからのメッセージを表示することを許可します。- Pub/Sub Subscriber

roles/pubsub.subscriber

このサービスアカウントが Google Cloud ログで Pub/Sub サブスクリプションからのメッセージを取得することを許可します。- Pub/Sub Publisher

roles/pubsub.publisher

このサービスアカウントが別のサブスクリプションに失敗したメッセージを公開することを許可します。これにより、ログの解析や再送信が可能になります。- Secret Manager Secret Accessor

roles/secretmanager.secretAccessor

このサービスアカウントが Secret Manager で Datadog API キーにアクセスすることを許可します。- Storage Object Admin

roles/storage.objectAdmin

このサービスアカウントがファイルのステージング用に指定された Cloud Storage バケットに対する読み取りと書き込みを行うことを許可します。

注: Dataflow パイプラインワーカー用のカスタムサービスアカウントを作成しない場合は、デフォルトの Compute Engine のサービスアカウントが上記の必要な権限を持っていることを確認してください。

3. Google Cloud Pub/Sub トピックからログをエクスポートする

Google Cloud コンソールの Logs Explorer ページに移動します。

Log Router タブより、Create Sink を選択します。

シンクに名前を設定します。

宛先として Cloud Pub/Sub を選択し、その目的で作成された Cloud Pub/Sub トピックを選択します。注: Cloud Pub/Sub トピックは別のプロジェクトに存在する場合があります。

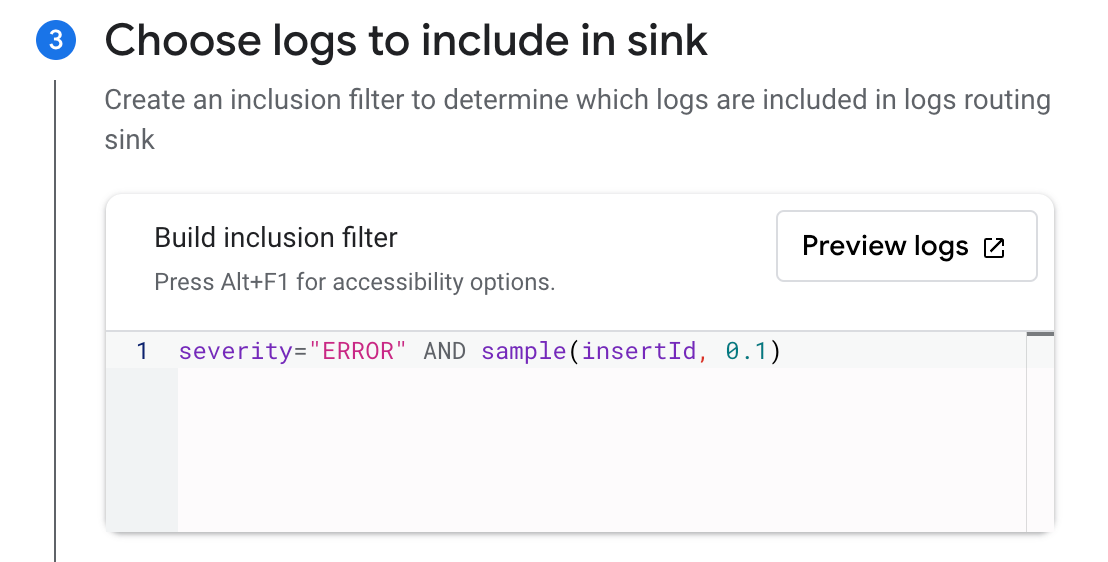

Choose the logs you want to include in the sink with an optional inclusion or exclusion filter. You can filter the logs with a search query, or use the sample function. For example, to include only 10% of the logs with a

severitylevel ofERROR, create an inclusion filter withseverity="ERROR" AND sample(insertId, 0.1).Create Sink をクリックします。

注: 異なるシンクを利用して、Google Cloud Logging から同一の Cloud Pub/Sub トピックに対して複数のエクスポートを行うことが可能です。

4. Dataflow ジョブを作成して実行する

Google Cloud コンソールのテンプレートからジョブを作成するページに移動します。

ジョブに名前を付け、Dataflow 地域エンドポイントを選択します。

Dataflow template ドロップダウンで

Pub/Sub to Datadogを選択すると、Required parameters セクションが表示されます。 a. Pub/Sub input subscription ドロップダウンで入力サブスクリプションを選択します。 b. Datadog Logs API URL フィールドに以下の値を入力します。https://注: 上記の URL をコピーする前に、ページの右側にある Datadog サイトセレクタが Datadog サイトに設定されていることを確認してください。

c. Output deadletter Pub/Sub topic ドロップダウンで、メッセージの失敗を受信するために作成されたトピックを選択します。 d. Temporary location フィールドで、ストレージバケット内の一時ファイルのパスを指定します。

Optional Parameters で

Include full Pub/Sub message in the payloadにチェックを入れます。ステップ 1 で言及したように Datadog API キーの値で Secret Manager にシークレットを作成した場合は、シークレットのリソース名を Google Cloud Secret Manager ID フィールドに入力します。

その他の使用可能なオプションの詳細については、Dataflow テンプレートのテンプレートパラメーターを参照してください。

apiKeyKMSEncryptionKeyを Cloud KMS のキー ID に設定し、apiKeyを暗号化された API キーに設定したapiKeySource=KMS- 非推奨:

apiKeySource=PLAINTEXTで、apiKeyにプレーンテキストの API キーを設定

- カスタムワーカーサービスアカウントを作成した場合は、Service account email ドロップダウンでそれを選択します。

- RUN JOB をクリックします。

注: 共有 VPC を使用している場合は、Dataflow ドキュメントのネットワークとサブネットワークを指定するページで Network と Subnetwork パラメーターの指定に関するガイドラインを参照してください。

検証

Cloud Pub/Sub トピックに配信された新しいログイベントは、Datadog ログエクスプローラーに表示されます。

注: Google Cloud Pricing Calculator を使用して、予想コストを計算できます。

Cloud Pub/Sub ログの転送を監視する

Google Cloud Pub/Sub インテグレーションは、ログ転送のステータスを監視するのに役立つメトリクスを提供します。

gcp.pubsub.subscription.num_undelivered_messagesは配信保留中のメッセージ数を表しますgcp.pubsub.subscription.oldest_unacked_message_ageは、サブスクリプション内の最も古い未承認メッセージの年齢を表します

上記のメトリクスをメトリクスモニターとともに使用すると、入力およびデッドレターサブスクリプション内のメッセージに対するアラートを受け取ることができます。

Dataflow パイプラインを監視する

Datadog の Google Cloud Dataflow インテグレーションを使用して、Dataflow パイプラインのあらゆる側面を監視することができます。すぐに使えるダッシュボード上で、Dataflow ワークロードを実行している GCE インスタンスに関する情報や Pub/Sub スループットなどのコンテキストデータでリッチ化された、すべての Dataflow 主要メトリクスを確認できます。

また、あらかじめ構成されている Recommended Monitor を使用して、パイプラインのバックログ時間の増加に対する通知をセットアップすることもできます。詳細は、Datadog ブログの Datadog による Dataflow パイプラインの監視を参照してください。

リソース変更の収集

Google の Cloud Asset Inventory がクラウドリソースの変更を検出すると、Datadog でリソースイベントを受け取ることができます。

Google Cloud インテグレーションページの Resource Collection タブで Enable Resource Collection を選択していることを確認します。次に、以下の手順に従って、変更イベントを Pub/Sub トピックから Datadog イベントエクスプローラー に転送します。

Cloud Pub/Sub トピックとサブスクリプションを作成する

トピックの作成

- Google Cloud Pub/Sub トピックページで、CREATE TOPIC をクリックします。

- トピックにわかりやすい名前をつけます。

- デフォルトのサブスクリプションを追加するオプションのチェックを外します。

- CREATE をクリックします。

サブスクリプションの作成

- Google Cloud Pub/Sub サブスクリプションページで、CREATE SUBSCRIPTION をクリックします。

- サブスクリプション名に

export-asset-changes-to-datadogと入力します。 - 先ほど作成した Cloud Pub/Sub トピックを選択します。

- 配信タイプとして Pull を選択します。

- CREATE をクリックします。

アクセス権を付与する

この Pub/Sub サブスクリプションから読み取るには、インテグレーション が使用する Google Cloud サービス アカウントに、サブスクリプションに対する pubsub.subscriptions.consume 権限が必要です。これを許可する最小限の権限を持つデフォルトのロールは Pub/Sub subscriber ロールです。このロールを付与するには、以下の手順に従います。

- Google Cloud Pub/Sub サブスクリプションページで、

export-asset-changes-to-datadogサブスクリプションをクリックします。 - ページ右側の情報パネルで、Permissions タブ をクリックします。情報パネルが表示されない場合は、SHOW INFO PANEL をクリックしてください。

- ADD PRINCIPAL をクリックします。

- Datadog Google Cloud インテグレーションが使用するサービスアカウントのメールアドレスを入力します。サービスアカウントは、Datadog の Google Cloud インテグレーションページの Configuration タブの左側に表示されます。

アセットフィードを作成する

Cloud Shell または gcloud CLI で以下のコマンドを実行し、上記で作成した Pub/Sub トピックに変更イベントを送信する Cloud Asset Inventory フィードを作成します。

gcloud asset feeds create <FEED_NAME>

--project=<PROJECT_ID>

--pubsub-topic=projects/<PROJECT_ID>/topics/<TOPIC_NAME>

--asset-names=<ASSET_NAMES>

--asset-types=<ASSET_TYPES>

--content-type=<CONTENT_TYPE>

--condition-title=<CONDITION_TITLE>

プレースホルダーの値を下記の要領で更新します。

<FEED_NAME>: Cloud Asset Inventory フィードのわかりやすい名前。<PROJECT_ID>: Google Cloud プロジェクト ID。

gcloud asset feeds create <FEED_NAME>

--folder=<FOLDER_ID>

--pubsub-topic=projects/<PROJECT_ID>/topics/<TOPIC_NAME>

--asset-names=<ASSET_NAMES>

--asset-types=<ASSET_TYPES>

--content-type=<CONTENT_TYPE>

--condition-title=<CONDITION_TITLE>

プレースホルダーの値を下記の要領で更新します。

<FEED_NAME>: Cloud Asset Inventory フィードのわかりやすい名前。<FOLDER_ID>: Google Cloud フォルダー ID.

gcloud asset feeds create <FEED_NAME>

--organization=<ORGANIZATION_ID>

--pubsub-topic=projects/<PROJECT_ID>/topics/<TOPIC_NAME>

--asset-names=<ASSET_NAMES>

--asset-types=<ASSET_TYPES>

--content-type=<CONTENT_TYPE>

--condition-title=<CONDITION_TITLE>

プレースホルダーの値を下記の要領で更新します。

<FEED_NAME>: Cloud Asset Inventory フィードのわかりやすい名前。<ORGANIZATION_ID>: Google Cloud 組織 ID.

<TOPIC_NAME>:export-asset-changes-to-datadogサブスクリプションにリンクされている Pub/Sub トピックの名前。<ASSET_NAMES>: 変更イベント を受け取るリソースのフルネームのカンマ区切りリスト。asset-typesを指定する場合はオプションになります。<ASSET_TYPES>: 変更イベント を受け取るアセットタイプのカンマ区切りリスト。asset-namesを指定する場合はオプションになります。<CONTENT_TYPE>: アセット 変更イベントを受け取るアセットのコンテンツタイプ (オプション)。<CONDITION_TITLE>: フィードに適用する条件のタイトル (オプション)。

Datadog では、すべてのリソースの変更を収集するために、asset-typesパラメーターを正規表現の .* に設定することを推奨しています。

注: asset-names またはasset-types パラメーターには、少なくとも 1 つの値を指定する必要があります。

設定可能なパラメータの一覧については、gcloud asset feeds create のリファレンスを参照してください。

検証

Datadog イベントエクスプローラーでアセット変更イベント を見つけます。

収集データ

メトリクス

メトリクスについては、個別の Google Cloud インテグレーションのページを参照してください。

累積メトリクス

累積メトリクスは、メトリクス名ごとに .delta メトリクスを伴って Datadog にインポートされます。累積メトリクスとは、値が時間の経過とともに常に増加するメトリクスです。たとえば、sent bytes のメトリクスは累積的である可能性があります。各値は、その時点でサービスによって送信された総バイト数を記録します。デルタ値は、前回の測定からの変化を表します。

例:

gcp.gke.container.restart_count は、CUMULATIVE (累積) メトリクスです。Datadog はこのメトリクスを累積メトリクスとしてインポートする際に、(CUMULATIVE メトリクスの一部として出力される集計値ではなく) デルタ値を含む gcp.gke.container.restart_count.delta メトリクスを追加します。詳細については、Google Cloud メトリクスの種類 を参照してください。

イベント

Google Cloud Platform によって生成されたすべてのサービスイベントが Datadog のイベントエクスプローラーに転送されます。

サービスチェック

Google Cloud Platform インテグレーションには、サービスのチェック機能は含まれません。

タグ

タグは、Google Cloud Platform と Google Compute Engine の様々な構成オプションに基づいて自動的に割り当てられます。project_id タグは、すべてのメトリクスに追加されます。追加のタグは、利用可能な場合に Google Cloud Platform から収集され、メトリクスの種類に応じて異なります。

また、Datadog は以下をタグとして収集します。

<key>:<value>ラベルが付けられたホスト。- Custom labels from Google Pub/Sub、GCE、Cloud SQL、Cloud Storage のカスタムラベル

トラブルシューティング

ユーザー定義の gcp.logging メトリクスに不正なメタデータが適用される

非標準の gcp.logging メトリクス (Datadog に標準で含まれるログメトリクス以外のメトリクスなど) に適用されるメタデータが Google Cloud Logging と一致しない場合があります。

このような場合は、メタデータを手動で設定する必要があります。設定するには、メトリクスサマリーページに移動し、問題のメトリクスを検索して選択し、メタデータの横にある鉛筆アイコンをクリックします。

ご不明な点は、Datadog のサポートチームまでお問い合わせください。