- Esenciales

- Empezando

- Agent

- API

- Rastreo de APM

- Contenedores

- Dashboards

- Monitorización de bases de datos

- Datadog

- Sitio web de Datadog

- DevSecOps

- Gestión de incidencias

- Integraciones

- Internal Developer Portal

- Logs

- Monitores

- OpenTelemetry

- Generador de perfiles

- Session Replay

- Security

- Serverless para Lambda AWS

- Software Delivery

- Monitorización Synthetic

- Etiquetas (tags)

- Workflow Automation

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Build an Integration with Datadog

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un dashboard de integración

- Create a Monitor Template

- Crear una regla de detección Cloud SIEM

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- OpenTelemetry

- Administrator's Guide

- API

- Partners

- Aplicación móvil de Datadog

- DDSQL Reference

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Reference Tables

- Hojas

- Monitores y alertas

- Watchdog

- Métricas

- Bits AI

- Internal Developer Portal

- Error Tracking

- Explorador

- Estados de problemas

- Detección de regresión

- Suspected Causes

- Error Grouping

- Bits AI Dev Agent

- Monitores

- Issue Correlation

- Identificar confirmaciones sospechosas

- Auto Assign

- Issue Team Ownership

- Rastrear errores del navegador y móviles

- Rastrear errores de backend

- Manage Data Collection

- Solucionar problemas

- Guides

- Change Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Status Pages

- Gestión de eventos

- Gestión de casos

- Actions & Remediations

- Infraestructura

- Cloudcraft

- Catálogo de recursos

- Universal Service Monitoring

- Hosts

- Contenedores

- Processes

- Serverless

- Monitorización de red

- Cloud Cost

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Recommendations

- Code Origin for Spans

- Observabilidad del servicio

- Endpoint Observability

- Instrumentación dinámica

- Live Debugger

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Límites de tasa del Agent

- Métricas de APM del Agent

- Uso de recursos del Agent

- Logs correlacionados

- Stacks tecnológicos de llamada en profundidad PHP 5

- Herramienta de diagnóstico de .NET

- Cuantificación de APM

- Go Compile-Time Instrumentation

- Logs de inicio del rastreador

- Logs de depuración del rastreador

- Errores de conexión

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Setting Up Amazon DocumentDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Exploring Database Schemas

- Exploring Recommendations

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Experiencia digital

- Real User Monitoring

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Análisis de productos

- Entrega de software

- CI Visibility

- CD Visibility

- Deployment Gates

- Test Visibility

- Configuración

- Network Settings

- Tests en contenedores

- Repositories

- Explorador

- Monitores

- Test Health

- Flaky Test Management

- Working with Flaky Tests

- Test Impact Analysis

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Code Coverage

- Quality Gates

- Métricas de DORA

- Feature Flags

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Code Security

- Cloud Security Management

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- CloudPrem

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Ayuda

Enviar logs de Azure Event Hubs a Observability Pipelines

Este producto no es compatible con el sitio Datadog seleccionado. ().

Información general

Este documento explica cómo enviar logs de Azure Event Hubs a Observability Pipelines utilizando la fuente de Kafka. Los pasos de configuración incluyen la configuración de Azure Event Hubs para la fuente de Kafka:

- Crear un espacio de nombres de Event Hubs

- Crear un Evenr Hub (tema de Kafka)

- Configurar política de acceso compartido

- Configurar ajustes de diagnóstico

- Configurar conexión compatible con Kafka para el centro de eventos

Después de configurar Azure Event Hubs, configura un pipeline con la fuente de Kafka para enviar los logs de Azure Event Hubs a Observability Pipelines.

Configurar Azure Event Hubs para la fuente de Kafka

Crear un espacio de nombres de Azure Event Hubs

- En el Portal Azure, navega hasta Event Hubs.

- Haz clic en Create (Crear).

- Rellena los detalles del proyecto (suscripción, grupo de recursos) y los detalles de la instancia (nombre del espacio de nombres, región, selecciona el nivel Estándar, Premium o Dedicado).

- Asegúrate de que la región coincide con tus recursos Azure (por ejemplo,

westus). - Haz clic en Review + create (Revisar + crear).

Nota: El endpoint de Kafka se habilita automáticamente para los niveles estándar y superiores.

Crear un centro de eventos (tema de Kafka)

- En el espacio de nombres que has creado, selecciona Event Hubs y haz clic en + Event Hub.

- Introduce un nombre (por ejemplo,

datadog-topic) y configura los ajustes (por ejemplo, 4 particiones y un tiempo de retención de 7 días). - Haz clic en Review + create (Revisar + crear). Este Event Hub actúa como un tema de Kafka.

Configurar la política de acceso compartido

- En el centro de eventos que has creado, ve a Settings > Shared access policies (Ajustes > Políticas de acceso compartido).

- Haz clic en + Add (+ Añadir).

- Introduce un nombre de política (por ejemplo,

DatadogKafkaPolicy). - Selecciona la casilla Manage (Gestionar), que debería seleccionar automáticamente las casillas Send (Enviar) y Listen (Escuchar).

- Haz clic en Create (Crear).

- La clave principal y la cadena de conexión principal son necesarias para la autenticación de Kafka cuando se configura la fuente de Kafka de Observability Pipelines.

Configurar los ajustes de diagnóstico

- Configurs los recursos de Azure (por ejemplo, VMs, App Services) o los logs de actividad a nivel de suscripción para transmitir logs al Event Hub.

- Para obtener recursos:

- Navega hasta el recurso y luego hasta Monitoring > Diagnostic settings (Monitorización > Ajustes de diagnóstico).

- Haz clic en + Add diagnostic setting (+ Añadir parámetro de diagnóstico).

- Selecciona las categorías de log que desees (por ejemplo, AuditLogs, SignInLogs para Microsoft Entra ID).

- En Destination details (Detalles del destino):

- Marca la casilla Stream to an event hub (Transmitir a un Event Hub).

- Selecciona el espacio de nombres y el Event Hub (

datadog-topic).

- Haz clic en Save (Guardar).

- Para los logs de actividad:

- Ve a Microsoft Entra ID > Monitoring > Audit logs > Export Data Settings (Microsoft Entra ID > Monitorización > Logs de auditoría > Ajustes de exportación de datos).

- Marca la casilla Stream to the Event Hub (Transmitir al Event Hub).

- Repítelo para cada región. Los logs deben transmitirse a los Events Hubs de la misma región.

Configurar una conexión compatible con Kafka para el Event Hub

Azure Event Hubs expone un endpoint de Kafka en NAMESPACE.servicebus.windows.net:9093, que Observability Pipelines utiliza como fuente de Kafka.

Obtener el endpoint de Kafka

- En el portal de Azure, navega hasta tu espacio de nombres de Event Hubs (por ejemplo,

myeventhubns). - En la página Overview (Información general), en la sección Essentials (Elementos esenciales), ubica el Host name (Nombre de host) o Fully Qualified Domain Name (FQDN). Tiene el siguiente formato:

<NAMESPACE>.servicebus.windows.net(por ejemplo:myeventhubns.servicebus.windows.net). - Añade el puerto de Kafka

:9093para formar el valor Bootstrap Servers (Servidores de arranque):<NAMESPACE>.servicebus.windows.net:9093.- Por ejemplo, si tu espacio de nombres es

myeventhubns, los servidores de arranque sonmyeventhubns.servicebus.windows.net:9093. - Necesitarás esta información cuando configures la fuente de Kafka de Observability Pipelines.

- Por ejemplo, si tu espacio de nombres es

Configurar la autenticación

- Azure Event Hubs utiliza SASL_SSL con el mecanismo PLAIN para la autenticación de Kafka.

- La cadena de conexión está formateada para Observability Pipelines:

Username: $$ConnectionString Password: Endpoint=sb://<NAMESPACE>.servicebus.windows.net/;SharedAccessKeyName=<PolicyName>;SharedAccessKey=<Key>

Configurar un pipeline con la fuente de Kafka

Selecciona tu plataforma.

Navega hasta Observability Pipelines.

Selecciona la fuente de Kafka.

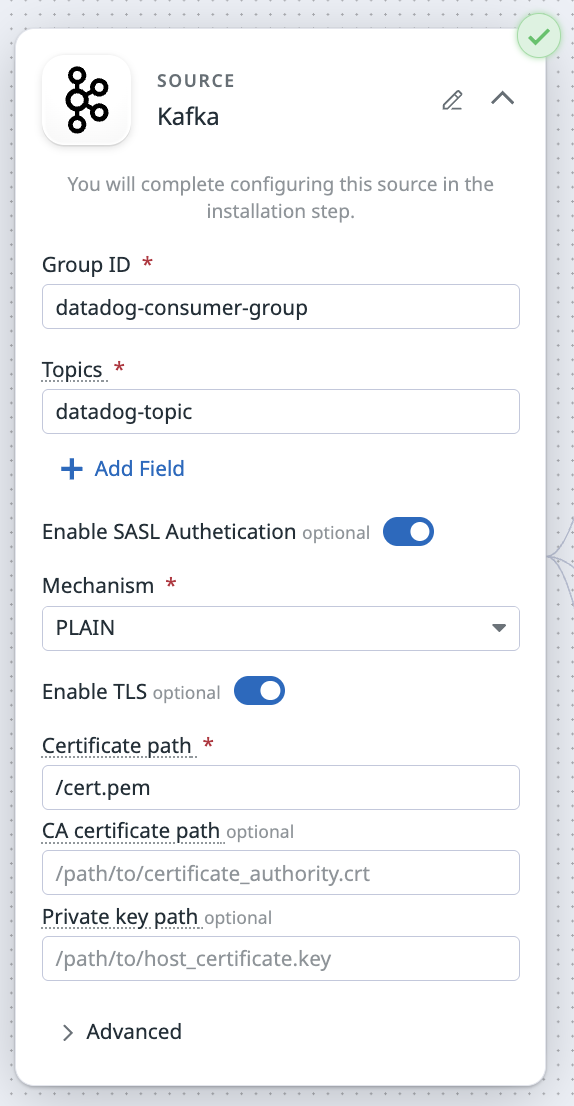

- En el campo Group ID (ID de grupo), especifica o crea un grupo de consumidores único (por ejemplo,

datadog-consumer-group). - En el campo Topics (Temas), introduce

datadog-topico el tema que configuraste anteriormente para tu Event Hub. - Activa el interruptor para habilitar la autenticación SASL.

- En el menú desplegable Mechanism (Mecanismo), selecciona PLAIN.

- Activa TLS.

- Configura tu archivo

values.yamlpara utilizar el certificado que forma parte de la imagen del contenedor:Nota: Al instalar el worker con el comando install es necesario añadir:initContainers: - name: copy-config image: gcr.io/datadoghq/observability-pipelines-worker:latest imagePullPolicy: IfNotPresent command: ['/bin/sh', '-c', 'mkdir -p /config-volume/observability-pipelines-worker/config/ && cp /etc/ssl/certs/ca-certificates.crt /config-volume/observability-pipelines-worker/config/ca-certificates.crt'] volumeMounts: - name: config-volume mountPath: /config-volume extraVolumes: - name: config-volume emptyDir: {} extraVolumeMounts: - name: config-volume mountPath: /config-volume--set env[0].name=DD_OP_DATA_DIR,env[0].value='/config-volume/observability-pipelines-worker/' - En el campo Certificate path (Ruta del certificado), introduce

/ca-certificates.crtsi has utilizado el ejemplo anterior. De lo contrario, introduce el nombre de tu certificado.

- Configura tu archivo

- En el campo Group ID (ID de grupo), especifica o crea un grupo de consumidores único (por ejemplo,

Pulsa Next: Select Destination (Siguiente: Seleccionar destino).

Después de configurar tus destinos y procesadores, haz clic en Next: Install (Siguiente: Instalar).

Selecciona tu plataforma en el menú desplegable Elige tu plataforma de instalación.

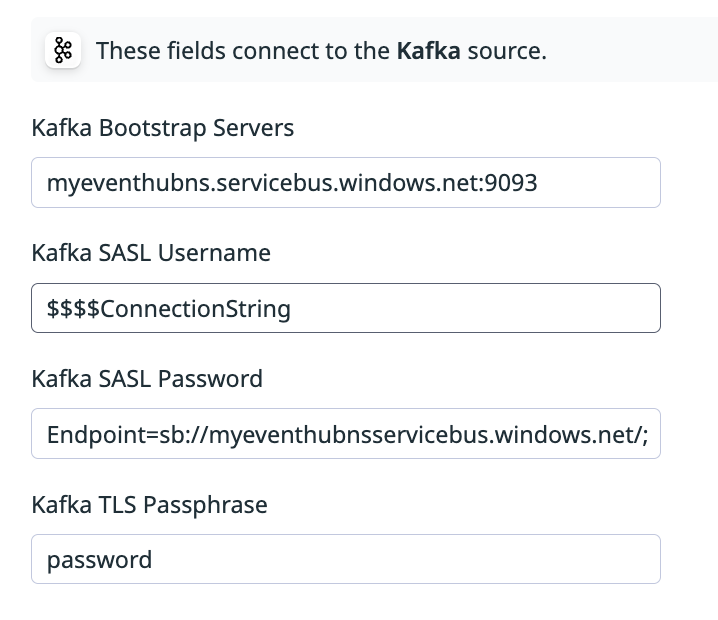

Introduce las variables de entorno para tu fuente de Kafka:

- Para Kafka Bootstrap Servers (Servidores de arranque de Kafka), introduce

<NAMESPACE>.servicebus.windows.net:9093(por ejemplo,myeventhubns.servicebus.windows.net:9093). - Para Kafka SASL Username (Nombre de usuario SASL de Kafka), introduce

$$$$ConnectionString. Nota: Debes poner$$$$delante deConnectionStringporque$$$$acaba siendo$$cuando se transpone al entorno. - Para Kafka SASL Password (Contraseña SASL de Kafka), introduce la cadena de conexión completa. Por ejemplo,

Endpoint=sb://<NAMESPACE>.servicebus.windows.net/;SharedAccessKeyName=<PolicyName>;SharedAccessKey=<Key>.- Esta es la cadena de conexión primaria en las [políticas de acceso compartido] de tu instancia de Event Hub(#configure-shared-access-policy).

- Introduce tu contraseña TLS de Kafka.

- Esta es la clave principal en las [políticas de acceso compartido] de tu instancia de Event Hub (#configure-shared-access-policy).

- Para Kafka Bootstrap Servers (Servidores de arranque de Kafka), introduce

Introduce las variables de entorno para tus destinos, si procede.

Sigue el resto de instrucciones en la página para instalar el Worker en función de tu plataforma.

Navega hasta Observability Pipelines.

Selecciona la fuente de Kafka.

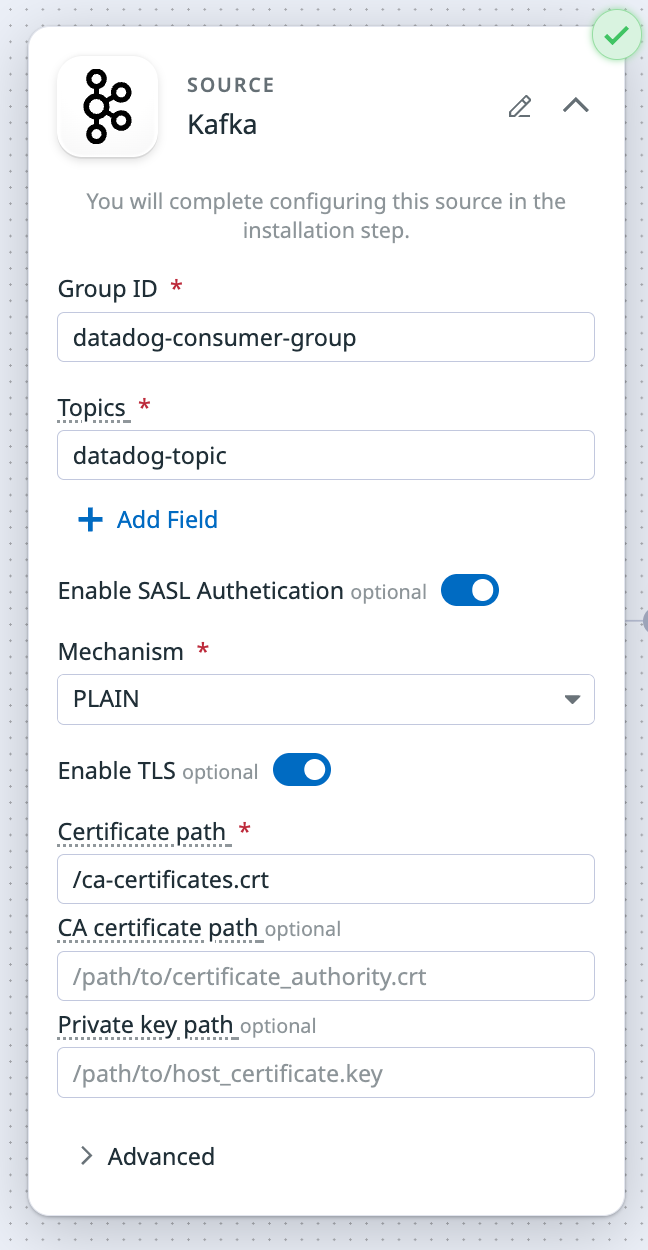

- En el campo Group ID (ID de grupo), especifica o crea un grupo de consumidores único (por ejemplo,

datadog-consumer-group). - Introduzca

datadog-topicen el campo Topics (Temas). - Activa el interruptor para habilitar la autenticación SASL.

- En el menú desplegable Mechanism (Mecanismo), selecciona PLAIN.

- Habilita TLS. Para el certificado, copia el certificado desde su ubicación original al directorio de configuración de datos por defecto de Observability Pipelines:

- Dado que aún no se ha instalado el worker de Observability Pipelines, ejecuta este comando para crear el directorio para el certificado:

sudo mkdir -p /var/lib/observability-pipelines-worker/config - Ejecuta este comando para copiar el certificado en el directorio que has creado:

sudo cp /etc/ssl/certs/ca-certificates.crt /var/lib/observability-pipelines-worker/config/ - En el campo Certificate path (Ruta del certificado), introduce

/ca-certificates.crt.

- Dado que aún no se ha instalado el worker de Observability Pipelines, ejecuta este comando para crear el directorio para el certificado:

- En el campo Group ID (ID de grupo), especifica o crea un grupo de consumidores único (por ejemplo,

Pulsa Next: Select Destination (Siguiente: Seleccionar destino).

Después de configurar tus destinos y procesadores, haz clic en Next: Install (Siguiente: Instalar).

Selecciona tu plataforma en el menú desplegable Elige tu plataforma de instalación.

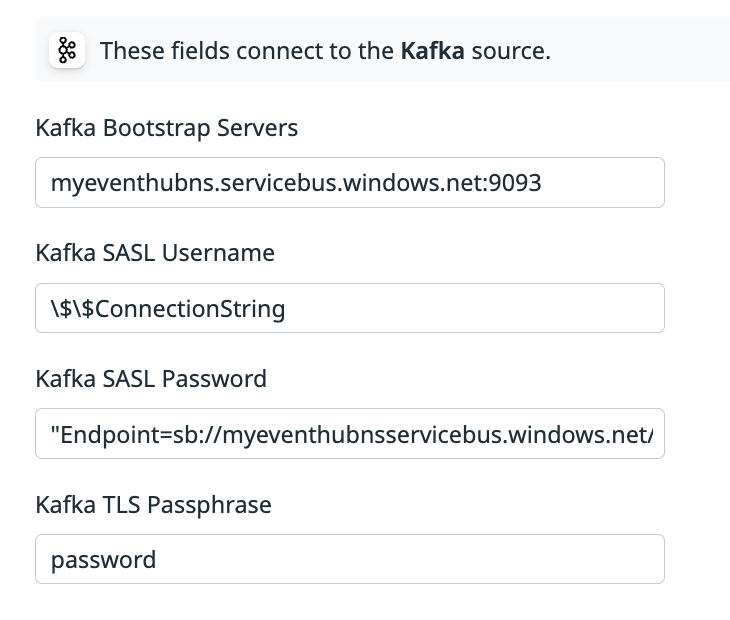

Introduce las variables de entorno para tu fuente de Kafka:

- Para Kafka Bootstrap Servers (Servidores de arranque de Kafka), introduce

<NAMESPACE>.servicebus.windows.net:9093(por ejemplo,myeventhubns.servicebus.windows.net:9093). - Para Kafka SASL Username (Nombre de usuario SASL de Kafka), introduce

\$\$ConnectionString. Nota: Debes escapar el$delante deConnectionString, de lo contrario la variable de entorno no se cargará. - Para Kafka SASL Password (Contraseña SASL de Kafka), introduce la cadena de conexión completa entre comillas (

"). Por ejemplo,"Endpoint=sb://<NAMESPACE>.servicebus.windows.net/;SharedAccessKeyName=<PolicyName>;SharedAccessKey=<Key>".- Esta es la cadena de conexión primaria en las [políticas de acceso compartido] de tu instancia de Event Hub(#configure-shared-access-policy).

- Introduce tu contraseña TLS de Kafka.

- Esta es la clave principal en las [políticas de acceso compartido] de tu instancia de Event Hub (#configure-shared-access-policy).

- Para Kafka Bootstrap Servers (Servidores de arranque de Kafka), introduce

Solucionar problemas

Si tienes problemas después de instalar el worker, comprueba tu archivo de entorno de Observability Pipelines (/etc/default/observability-pipelines-worker) para asegurarte de que las variables de entorno están correctamente configuradas:

DD_OP_SOURCE_KAFKA_SASL_USERNAME="$$ConnectionString"DD_OP_SOURCE_KAFKA_BOOTSTRAP_SERVERS=<NAMESPACE>.servicebus.windows.net:9093DD_OP_SOURCE_KAFKA_SASL_PASSWORD=<Endpoint=sb://<NAMESPACE>.servicebus.windows.net/;SharedAccessKeyName=<PolicyName>;SharedAccessKey=<Key>>DD_OP_SOURCE_KAFKA_KEY_PASS=password

Falta una variable de entorno

Si ves el error Missing environment variable DD_OP_SOURCE_KAFKA_SASL_PASSWORD y estás ejecutando el worker en una VM, asegúrate de que la variable está entre comillas (") cuando ejecutes el script de instalación del worker. Por ejemplo:

DD_OP_SOURCE_KAFKA_SASL_PASSWORD=`"Endpoint=sb://<NAMESPACE>.servicebus.windows.net/;SharedAccessKeyName=<PolicyName>;SharedAccessKey=<Key>"`