- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

Destino de Amazon S3

This product is not supported for your selected Datadog site. ().

El destino de Amazon S3 se encuentra disponible para la plantilla de Archivar logs. Usa este destino a fin de enviar tus logs en un formato que pueda volver a usar Datadog a un bucket de Amazon S3 para archivarlos. Debes configurar los archivos de log de Datadog si aún no lo has hecho y, a continuación, configurar el destino en la interfaz de usuario del pipeline.

Configurar los archivos de log

Si ya tienes un archivo de log de Datadog configurado para Observability Pipelines, pasa a Configurar el destino para tu pipeline.

Debes tener instalada la integración de AWS de Datadog para configurar los archivos de log de Datadog.

Create an Amazon S3 bucket

- Navigate to Amazon S3 buckets.

- Click Create bucket.

- Enter a descriptive name for your bucket.

- Do not make your bucket publicly readable.

- Optionally, add tags.

- Click Create bucket.

Set up an IAM policy that allows Workers to write to the S3 bucket

- Navigate to the IAM console.

- Select Policies in the left side menu.

- Click Create policy.

- Click JSON in the Specify permissions section.

- Copy the below policy and paste it into the Policy editor. Replace

<MY_BUCKET_NAME>and<MY_BUCKET_NAME_1_/_MY_OPTIONAL_BUCKET_PATH_1>with the information for the S3 bucket you created earlier.{ "Version": "2012-10-17", "Statement": [ { "Sid": "DatadogUploadAndRehydrateLogArchives", "Effect": "Allow", "Action": ["s3:PutObject", "s3:GetObject"], "Resource": "arn:aws:s3:::<MY_BUCKET_NAME_1_/_MY_OPTIONAL_BUCKET_PATH_1>/*" }, { "Sid": "DatadogRehydrateLogArchivesListBucket", "Effect": "Allow", "Action": "s3:ListBucket", "Resource": "arn:aws:s3:::<MY_BUCKET_NAME>" } ] } - Click Next.

- Enter a descriptive policy name.

- Optionally, add tags.

- Click Create policy.

Create a service account

Create a service account to use the policy you created above.

Conectar el bucket de S3 a archivos de logs de Datadog

- Navega a Reenvío de logs de Datadog.

- Haz clic en New archive (Nuevo archivo).

- Introduce un nombre de archivo descriptivo.

- Añade una consulta que filtre todos los logs que pasen por los pipelines de log para que ninguno de esos logs entre en este archivo. Por ejemplo, añade la consulta

observability_pipelines_read_only_archive, suponiendo que ningún log que pase por el pipeline tenga esa etiqueta añadida. - Selecciona AWS S3.

- Selecciona la cuenta de AWS en la que se encuentra tu bucket.

- Introduce el nombre del bucket de S3.

- Opcionalmente, introduce una ruta.

- Comprueba la declaración de confirmación.

- Opcionalmente, añade etiquetas y define el tamaño máximo de escaneado para la rehidratación. Consulta Configuración avanzada para obtener más información.

- Haz clic en Save (Guardar).

Para más información, consulta la documentación de archivos de log.

Configurar el destino para tu pipeline

Configura el destino de Amazon S3 y sus variables de entorno cuando configures un pipeline de Archivar logs. La siguiente información se configura en la interfaz de usuario del pipeline.

- Enter the S3 bucket name for the S3 bucket you created earlier.

- Enter the AWS region the S3 bucket is in.

- Enter the key prefix.

- Prefixes are useful for partitioning objects. For example, you can use a prefix as an object key to store objects under a particular directory. If using a prefix for this purpose, it must end in

/to act as a directory path; a trailing/is not automatically added. - See template syntax if you want to route logs to different object keys based on specific fields in your logs.

- Note: Datadog recommends that you start your prefixes with the directory name and without a lead slash (

/). For example,app-logs/orservice-logs/.

- Prefixes are useful for partitioning objects. For example, you can use a prefix as an object key to store objects under a particular directory. If using a prefix for this purpose, it must end in

- Select the storage class for your S3 bucket in the Storage Class dropdown menu. If you are going to archive and rehydrate your logs:

- Note: Rehydration only supports the following storage classes:

- Standard

- Intelligent-Tiering, only if the optional asynchronous archive access tiers are both disabled.

- Standard-IA

- One Zone-IA

- If you wish to rehydrate from archives in another storage class, you must first move them to one of the supported storage classes above.

- See the Example destination and log archive setup section of this page for how to configure your Log Archive based on your Amazon S3 destination setup.

- Note: Rehydration only supports the following storage classes:

- Optionally, select an AWS authentication option. If you are only using the user or role you created earlier for authentication, do not select Assume role. The Assume role option should only be used if the user or role you created earlier needs to assume a different role to access the specific AWS resource and that permission has to be explicitly defined.

If you select Assume role:- Enter the ARN of the IAM role you want to assume.

- Optionally, enter the assumed role session name and external ID.

- Note: The user or role you created earlier must have permission to assume this role so that the Worker can authenticate with AWS.

Example destination and log archive setup

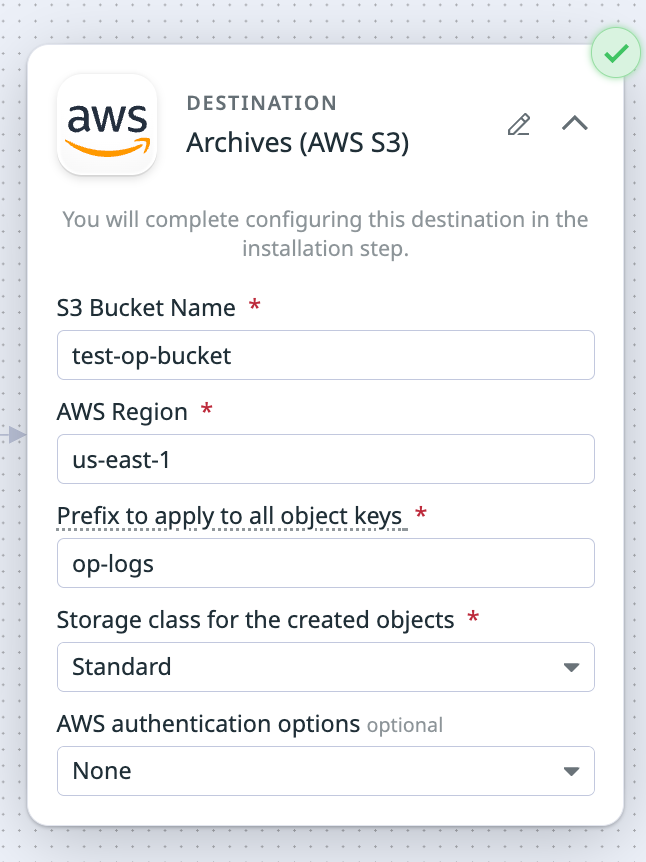

If you enter the following values for your Amazon S3 destination:

- S3 Bucket Name:

test-op-bucket - Prefix to apply to all object keys:

op-logs - Storage class for the created objects:

Standard

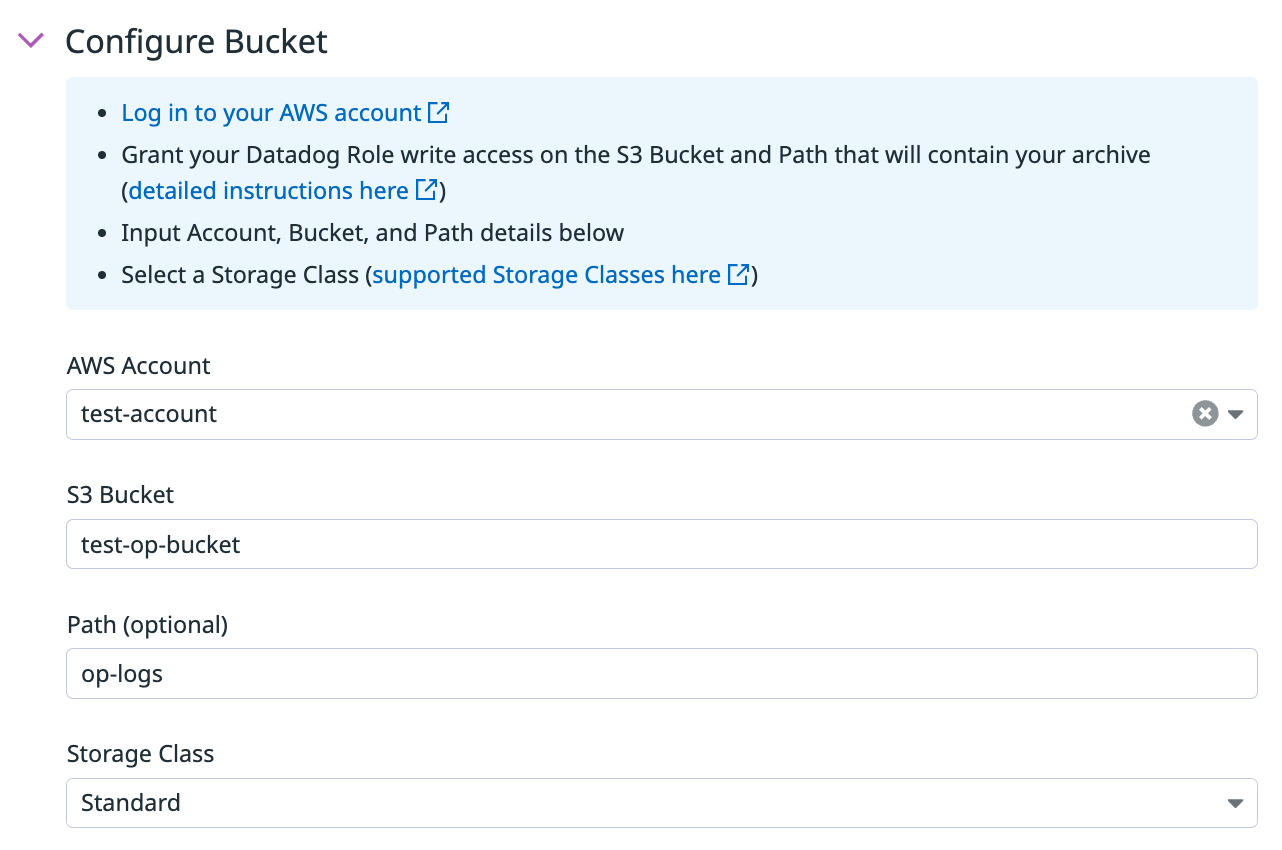

Then these are the values you enter for configuring the S3 bucket for Log Archives:

- S3 bucket:

test-op-bucket - Path:

op-logs - Storage class:

Standard

Establecer las variables de entorno

There are no environment variables to configure.

Funcionamiento del destino

Procesamiento por lotes de eventos

Se elimina un lote de eventos cuando se cumple uno de estos parámetros. Consulta el procesamiento por lotes de eventos para obtener más información.

| Máximo de eventos | Máximo de bytes | Tiempo de espera (segundos) |

|---|---|---|

| Ninguno | 100,000,000 | 900 |