- Esenciales

- Empezando

- Agent

- API

- Rastreo de APM

- Contenedores

- Dashboards

- Monitorización de bases de datos

- Datadog

- Sitio web de Datadog

- DevSecOps

- Gestión de incidencias

- Integraciones

- Internal Developer Portal

- Logs

- Monitores

- OpenTelemetry

- Generador de perfiles

- Session Replay

- Security

- Serverless para Lambda AWS

- Software Delivery

- Monitorización Synthetic

- Etiquetas (tags)

- Workflow Automation

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Build an Integration with Datadog

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un dashboard de integración

- Create a Monitor Template

- Crear una regla de detección Cloud SIEM

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- OpenTelemetry

- Administrator's Guide

- API

- Partners

- Aplicación móvil de Datadog

- DDSQL Reference

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Reference Tables

- Hojas

- Monitores y alertas

- Watchdog

- Métricas

- Bits AI

- Internal Developer Portal

- Error Tracking

- Explorador

- Estados de problemas

- Detección de regresión

- Suspected Causes

- Error Grouping

- Bits AI Dev Agent

- Monitores

- Issue Correlation

- Identificar confirmaciones sospechosas

- Auto Assign

- Issue Team Ownership

- Rastrear errores del navegador y móviles

- Rastrear errores de backend

- Manage Data Collection

- Solucionar problemas

- Guides

- Change Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Status Pages

- Gestión de eventos

- Gestión de casos

- Actions & Remediations

- Infraestructura

- Cloudcraft

- Catálogo de recursos

- Universal Service Monitoring

- Hosts

- Contenedores

- Processes

- Serverless

- Monitorización de red

- Cloud Cost

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Recommendations

- Code Origin for Spans

- Observabilidad del servicio

- Endpoint Observability

- Instrumentación dinámica

- Live Debugger

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Límites de tasa del Agent

- Métricas de APM del Agent

- Uso de recursos del Agent

- Logs correlacionados

- Stacks tecnológicos de llamada en profundidad PHP 5

- Herramienta de diagnóstico de .NET

- Cuantificación de APM

- Go Compile-Time Instrumentation

- Logs de inicio del rastreador

- Logs de depuración del rastreador

- Errores de conexión

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Setting Up Amazon DocumentDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Exploring Database Schemas

- Exploring Recommendations

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Experiencia digital

- Real User Monitoring

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Análisis de productos

- Entrega de software

- CI Visibility

- CD Visibility

- Deployment Gates

- Test Visibility

- Configuración

- Network Settings

- Tests en contenedores

- Repositories

- Explorador

- Monitores

- Test Health

- Flaky Test Management

- Working with Flaky Tests

- Test Impact Analysis

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Code Coverage

- Quality Gates

- Métricas de DORA

- Feature Flags

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Code Security

- Cloud Security Management

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- CloudPrem

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Ayuda

Snowflake

Información general

La nueva integración de Snowflake reemplaza la integración de Snowflake basada en el Agent de Datadog y ofrece funciones adicionales. Después de configurar la nueva integración de Snowflake, se recomienda desinstalar la integración de Snowflake basada en el Agent para reducir el volumen de llamadas a la API para Snowflake.

Puede resultar difícil monitorizar y optimizar eficazmente la infraestructura y la recuperación de datos de Snowflake. Surgen problemas que pueden derivar en una utilización ineficiente de los recursos, mayores costes y una experiencia del cliente degradada.

Con la integración Snowflake de Datadog, puedes detectar consultas de larga duración para mejorar el rendimiento y reducir los costes, identificar amenazas de seguridad en tiempo real y monitorizar tus cargas de trabajo de Snowpark.

Después de analizar los datos de Snowflake, Datadog completa el dashboard de información general listo para usar con información sobre todos los recursos recopilados. También ofrece monitores recomendados para ayudarte a comenzar a generar alertas sobre ejecuciones fallidas de Snowpark o una cantidad anormal de intentos de inicio de sesión.

Nota: Las métricas se recopilan mediante consultas a Snowflake. Las consultas realizadas mediante la integración de Datadog se facturan a través de Snowflake.

Configuración

Instalación

No se requiere ningún paso de instalación.

Configuración

Nota: Las cuentas de Snowflake conectadas a través de PrivateLink no son compatibles actualmente con la integración Snowflake.

Se recomienda la integración del Snowflake original con el Agent para configuraciones de PrivateLink.

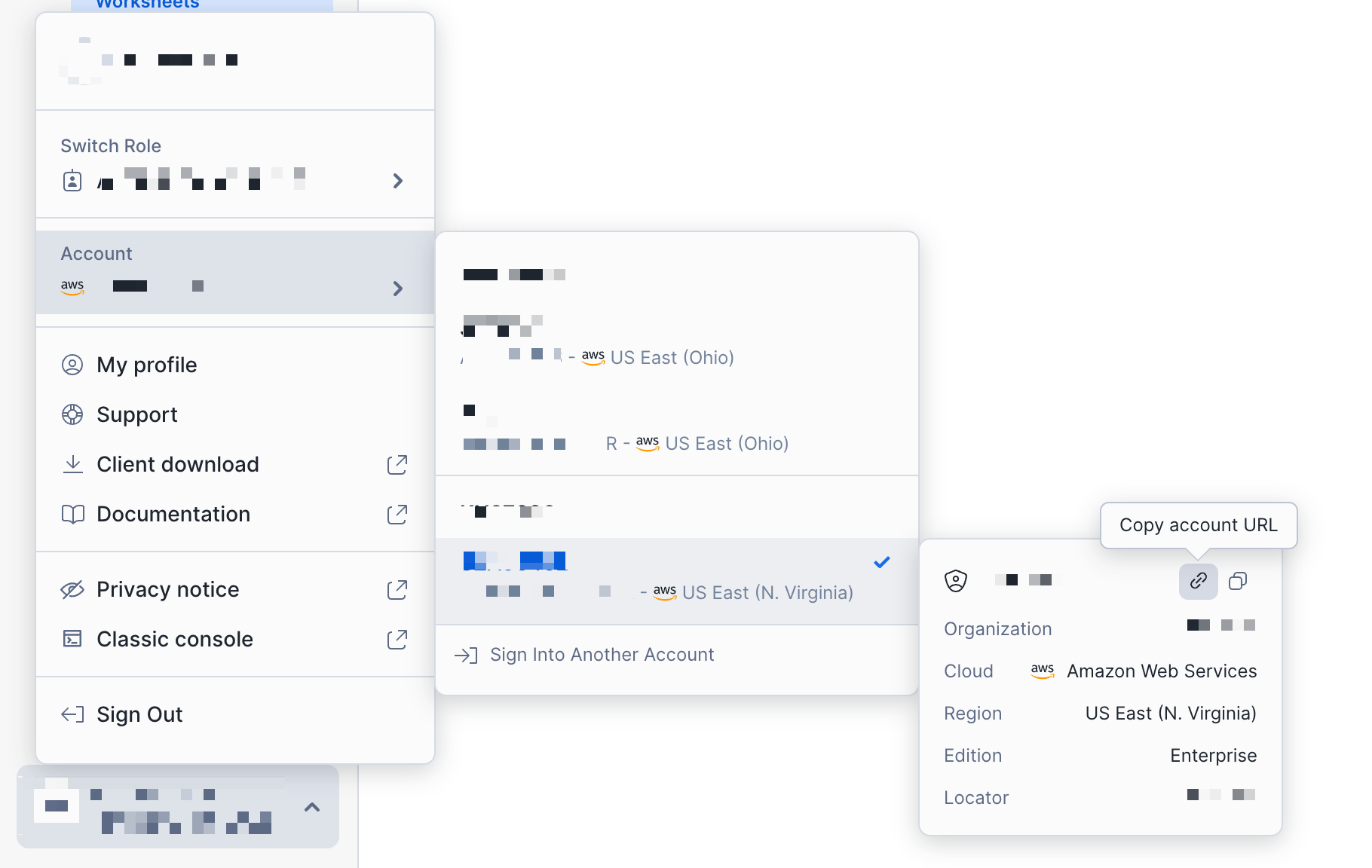

Conecta tu cuenta de Snowflake

- Busca la URL de tu cuenta de Snowflake.

En el cuadro de la integración de Snowflake, ingresa la URL de la cuenta de Snowflake en el campo URL de la cuenta.

En la pestaña Recopilación de recursos, activa los recursos que quieres recopilar:

Métricas de uso de cuentas y organizaciones

En la siguiente tabla se describen los tipos de métricas recopiladas y sus prefijos de métricas asociados.

| Tipo | Descripción | Prefijos de métricas recopilados |

|---|---|---|

| Uso de la cuenta | Uso de almacenamiento, consumo de crédito y métricas de consulta a nivel de cuenta. Recopilados por hora. | snowflake.auto_reclustersnowflake.billingsnowflake.data_transfersnowflake.loginssnowflake.pipesnowflake.querysnowflake.replicationsnowflake.storagesnowflake.storage.databasesnowflake.storage.table |

| Uso de la organización | Consumo de crédito, historial de transferencia de datos y métricas de presupuesto a nivel de organización. Recopilados por día. | snowflake.organization |

Estas métricas pueden recopilarse en uno de dos periodos:

- Últimas 24 horas: Recopila las métricas agregadas por las últimas 24 horas. Ejemplo: 1-01-25 04:00:00 a 1-02-25 04:00:00.

- Día actual: Recopila las métricas agregadas por el día actual. Ejemplo: 1-02-25 00:00:00 a 1-02-25 04:00:00.

Logs

La siguiente tabla describe los tipos de logs recopilados y qué tablas de Snowflake están incluidas.

| Tipo | Descripción | Tablas necesarias |

| Historial de consultas | Historial de ejecuciones de consultas. Los logs del historial de consultas se pueden enriquecer con logs del historial de acceso para brindar más información sobre cómo se utilizan los datos a través de las consultas y su linaje. | SNOWFLAKE.ACCOUNT_USAGE.QUERY_HISTORY |

| Seguridad | Utiliza estos logs con Cloud SIEM para detectar y responder mejor a las amenazas de seguridad en tu entorno. | SNOWFLAKE.ACCOUNT_USAGE.LOGIN_HISTORY SNOWFLAKE.ACCOUNT_USAGE.SESSIONS SNOWFLAKE.ACCOUNT_USAGE.GRANTS_TO_USERS SNOWFLAKE.ACCOUNT_USAGE.DATA_TRANSFER_HISTORY SNOWFLAKE.ACCOUNT_USAGE.STAGES |

| Tabla de eventos | Datos de mensajes y eventos generados por tus funciones y procedimientos. Requiere privilegios GRANT adicionales. | Tu tabla de eventos personalizada |

Estos logs pueden recopilarse en varios periodos en función del caso de uso. Pueden configurarse en el cuadro de la integración Snowflake.

Cloud Cost Management

Activa Cloud Cost Management para recibir las métricas de costes de Snowflake agregadas desde la tabla SNOWFLAKE.ORGANIZATION_USAGE.USAGE_IN_CURRENCY_DAILY. Puedes utilizar estas métricas con Cloud Cost Management para obtener información adicional sobre tus costes y tu uso.

- Crea un rol y un usuario específicos de Datadog para monitorizar Snowflake. Ejecuta la serie de comandos que se indican a continuación en tu entorno de Snowflake para crear un usuario al que Datadog pueda acceder.

Configuración de almacén recomendada

- Crea un almacén XS con un tiempo de suspensión automática de 30 segundos.

- Opcionalmente, utilizar un almacén XS existente que suela estar activo a lo largo del día puede ser la opción más rentable. Nota: Las consultas realizadas desde esta integración pueden afectar potencialmente al rendimiento de un almacén existente. No se recomienda ejecutar la integración en un almacén donde el rendimiento de las consultas es crítica.

-- Create a new role intended to monitor Snowflake usage. The name of the role is customizable.

create role DATADOG;

-- Grant privileges on the SNOWFLAKE database to the new role.

grant imported privileges on database SNOWFLAKE to role DATADOG;

-- Grant usage to your default warehouse to the role DATADOG.

grant usage on warehouse <WAREHOUSE> to role DATADOG;

-- Grant the following ACCOUNT_USAGE views to the new role. Do this if you wish to collect Snowflake account usage logs and metrics.

grant database role SNOWFLAKE.OBJECT_VIEWER to role DATADOG;

grant database role SNOWFLAKE.USAGE_VIEWER to role DATADOG;

grant database role SNOWFLAKE.GOVERNANCE_VIEWER to role DATADOG;

grant database role SNOWFLAKE.SECURITY_VIEWER to role DATADOG;

-- Grant ORGANIZATION_USAGE_VIEWER to the new role. Do this if you wish to collect Snowflake organization usage metrics.

grant database role SNOWFLAKE.ORGANIZATION_USAGE_VIEWER to role DATADOG;

-- Grant ORGANIZATION_BILLING_VIEWER to the new role. Do this if you wish to collect Snowflake cost data.

grant database role SNOWFLAKE.ORGANIZATION_BILLING_VIEWER to role DATADOG;

-- Grant usage on the database, schema, and table of the event table.

grant usage on database <EVENT_TABLE_DATABASE> to role DATADOG;

grant usage on schema <EVENT_TABLE_DATABASE>.<EVENT_TABLE_SCHEMA> to role DATADOG;

grant select on table <EVENT_TABLE_DATABASE>.<EVENT_TABLE_SCHEMA>.<EVENT_TABLE_NAME> to role DATADOG;

grant application role SNOWFLAKE.EVENTS_VIEWER to role DATADOG;

grant application role SNOWFLAKE.EVENTS_ADMIN to role DATADOG;

-- Grant usage on the database, schema, and table of your tables for metric collection of your custom queries.

grant usage on database <CUSTOM_QUERY_DATABASE> to role DATADOG;

grant usage on schema <CUSTOM_QUERY_DATABASE>.<CUSTOM_QUERY_SCHEMA> to role DATADOG;

grant select on table <CUSTOM_QUERY_DATABASE>.<CUSTOM_QUERY_SCHEMA>.<CUSTOM_QUERY_TABLE> to role DATADOG;

-- Create a user.

create user <USERNAME>

LOGIN_NAME = <USERNAME>

password = '<PASSWORD>'

default_warehouse =<WAREHOUSE>

default_role = DATADOG;

-- Grant the monitor role to the user.

grant role DATADOG to user <USERNAME>

- Configura la autenticación por par de claves. La clave pública se asigna al usuario creado anteriormente y la clave privada se carga en Datadog, lo que permite que Datadog se conecte a tu cuenta de Snowflake. a. Crea y carga una clave privada siguiendo las instrucciones de Snowflake. Actualmente, Datadog solo admite claves privadas sin cifrar. b. Crea una clave pública siguiendo las instrucciones de Snowflake. c. Asigna la clave pública al usuario creado anteriormente siguiendo las instrucciones de Snowflake.

Ciertos prefijos de direcciones IP deben estar en la lista de permitidos para que Datadog recopile datos de tu cuenta de Snowflake. La lista de prefijos de IP que pertenecen a Datadog se puede encontrar en la página de rangos IP y el rango permitido se puede encontrar en Webhooks.

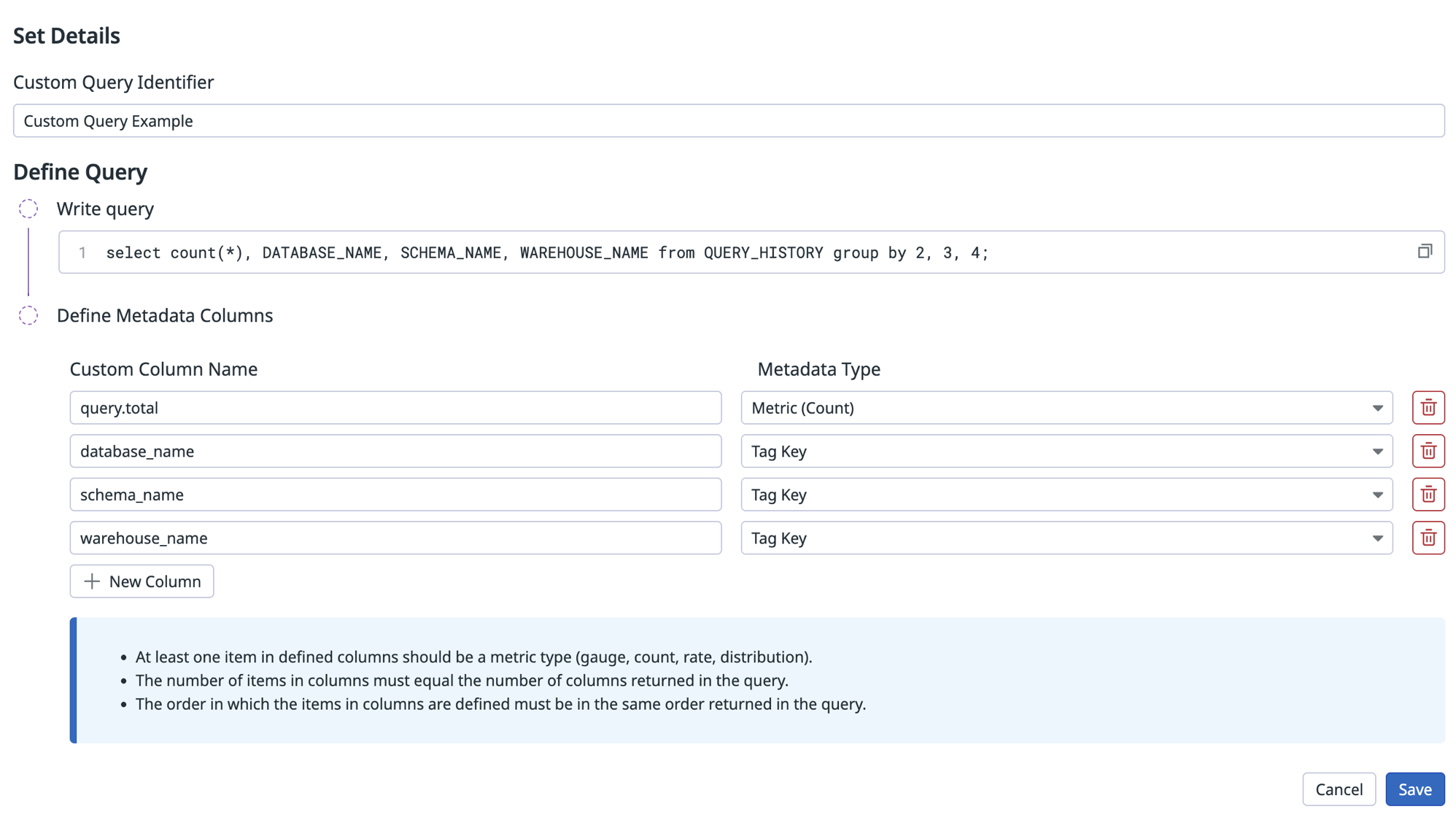

Métricas personalizadas

La integración Snowflake admite consultas personalizadas para recopilar métricas personalizadas. Los usuarios pueden escribir consultas SQL personalizadas para extraer datos específicos y verlos como métricas y etiquetas (tags) de métricas en Datadog. Las consultas con varias líneas deben tener cada consulta en su propia línea.

Por defecto, la integración se conecta a la base de datos compartida SNOWFLAKE y al esquema ACCOUNT_USAGE. Si estás consultando una tabla fuera del esquema ACCOUNT_USAGE, asegúrate de que tu rol configurado tenga los permisos apropiados para acceder a la tabla.

La tabla siguiente describe los campos utilizados para definir métricas personalizadas.

| Campo | Descripción | Obligatorio |

|---|---|---|

| Custom Metric Identifier | Se trata de un identificador para la métrica personalizada, que se utiliza para vincular diferentes métricas personalizadas a sus respectivas consultas personalizadas en cada cuenta. | Sí |

| Consulta | Esta es la consulta SQL que se debe ejecutar. Puede ser una sentencia simple o un script de varias líneas. Se evalúan todas las filas de los resultados. | Sí |

| Columnas de metadatos | Se trata de una lista que representa cada columna ordenada secuencialmente de izquierda a derecha. Hay dos campos obligatorios para cada columna: - Nombre de columna personalizado: este es el sufijo que se añade a metric_prefix para formar el nombre completo de la métrica. Por ejemplo, my_custom_metric.count da como resultado el nombre completo de la métrica snowflake.my_custom_metric.count. Si el tipo se especifica como Tag Key, la columna se aplica como una etiqueta a cada métrica recopilada por esta consulta.- Tipo de metadatos: este es el método de envío (por ejemplo, gauge, recuento o tasa). También se puede establecer para etiquetar cada métrica de la fila con el nombre y el valor ( <NAME>:<ROW_VALUE>) del elemento de esta columna. | Sí |

Notas:

- Al menos un elemento en las columnas definidas debe ser un tipo de métrica (gauge, count, tasa, distribución).

- El número de elementos en las columnas debe ser igual a la cantidad de columnas devueltas en la consulta.

- El orden en que se definen los elementos en las columnas debe ser el mismo orden en que se devuelven en la consulta.

Ejemplo:

Validación

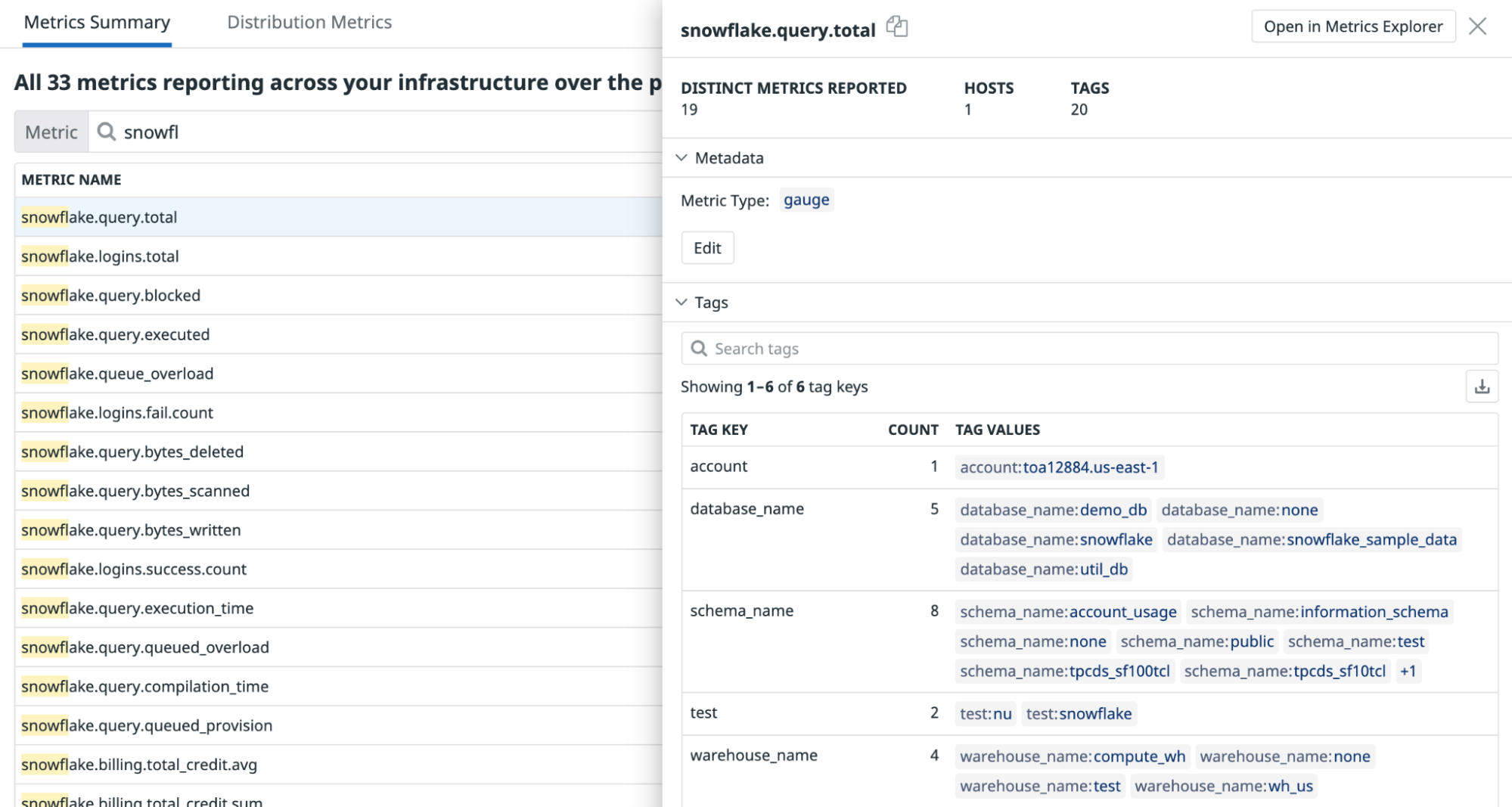

Para verificar el resultado, busca las métricas utilizando el resumen de métricas:

Tablas de referencia

Las tablas de referencia te permiten enriquecer y unir automáticamente tu telemetría con campos adicionales de tus tablas de Snowflake. Al asignar campos de valor a una clave primaria, puedes añadir automáticamente estos campos a logs o eventos que contengan esa clave.

Activar la ingesta de tablas de referencia

Ve a tu espacio de trabajo de Snowflake.

Identifica el nombre de la tabla de Snowflake que se utilizará en Datadog.

Concede a Datadog permisos de lectura de la tabla ejecutando el siguiente comando en tu espacio de trabajo.

GRANT USAGE ON DATABASE <REFERENCE_TABLE_DATABASE> TO ROLE DATADOG; GRANT USAGE ON SCHEMA <REFERENCE_TABLE_DATABASE>.<REFERENCE_TABLE_SCHEMA> TO ROLE DATADOG; GRANT SELECT ON TABLE <REFERENCE_TABLE_DATABASE>.<REFERENCE_TABLE_SCHEMA>.<REFERENCE_TABLE_NAME> TO ROLE DATADOG;- Si te encuentras con el error Insufficient Privileges (Privilegios insuficientes), ponte en contacto con el administrador de Snowflake de tu organización para que te conceda estos permisos. Datadog no podrá ingerir tu tabla de Snowflake en tablas de referencia sin los permisos anteriores concedidos en tu tabla de Snowflake.

Copia el nombre de la tabla y la clave principal para utilizarlos en la configuración de la tabla de referencia en el paso 6.

En Datadog, ve al cuadro de Snowflake y haz clic en la pestaña Tablas de referencia de la cuenta de la que quieres ingerir tablas. Si no tienes ninguna cuenta configurada, sigue las instrucciones de la sección Configuración.

Haz clic en el botón Add New Reference Table (Añadir nueva tabla de referencia). Cuando se abra el formulario, rellena los siguientes campos:

- Nombre de la tabla de Datadog, para identificar la tabla en el producto Tablas de referencia de Datadog. El nombre de tu tabla de Datadog debe contener caracteres y guiones bajos para separar varias palabras (por ejemplo,

my_reference_table). Asegúrate de que el nombre de tu tabla de referencia de Datadog es único en tu organización. - Nombre de la tabla de Snowflake que quieres ingerir, copiada del paso 4.

- Clave primaria de la tabla de Snowflake copiada del paso 4.

- Haz clic en Save (Guardar).

- Puedes esperar ver datos de servicio rellenados en Datadog, varios minutos después de las ejecuciones programadas de tus consultas.

Cualquier error de ingesta se notificará mediante eventos visibles en tu Explorador de eventos, buscando

source:snowflake. - Ve a Tablas de referencia y busca la tabla que acabas de crear, utilizando el nombre de la tabla de Datadog.

- Revisa el estado de tu tabla de Snowflake que se encuentra en la sección Archivo. Si aparece algún error, resuélvelo en Snowflake.

Prácticas recomendadas para la ingesta de tablas de Snowflake en tablas de referencia de Datadog

Al integrar datos de Snowflake en Datadog, es importante estructurar las tablas de forma eficiente para optimizar el rendimiento y los costes. Esta sección te ofrece recomendaciones sobre cómo preparar tus tablas de Snowflake para la ingesta.

Cómo Datadog ingiere tus datos

Datadog ejecuta la siguiente consulta cada hora en la tabla de Snowflake especificada:

SELECT * FROM your_table;

Dado que esta operación recupera todas las columnas y filas, Datadog recomienda especialmente crear una vista que incluya sólo los campos necesarios requeridos para la monitorización en Datadog. Esto ayuda a reducir la transferencia innecesaria de datos y los costes de procesamiento.

Utilizar una vista para limitar los datos

En lugar de exponer una tabla completa, crea una vista que seleccione sólo las columnas necesarias:

CREATE VIEW my_datadog_view AS

SELECT my_column_1, my_column_2

FROM my_raw_table;

Para obtener más información, consulta la documentación de las vistas de Snowflake.

Consideraciones relativas al rendimiento y los costes

En algunos casos, una vista estándar puede no ser la opción más eficaz, sobre todo si:

- La consulta es compleja (por ejemplo, implica uniones, agregaciones o subconsultas).

- El tiempo de ejecución de

SELECT *es de varios minutos o más. - La frecuencia de ingesta se traduce en elevados costes de computación. Para monitorizar tus costes de Snowflake, te recomendamos utilizar Snowflake Cloud Cost Management.

Para mejorar la eficiencia, considera alternativas como vistas materializadas, tablas dinámicas o tablas precalculadas.

Elegir la estructura de tabla adecuada

| Opción | Cuándo utilizarlo | Compensaciones |

|---|---|---|

| Vista materializada | La consulta es costosa desde el punto de vista informático y el rendimiento es crítico. | Mejora la velocidad de consulta, pero aumenta los costes de almacenamiento y requiere una lógica de actualización. |

| Tabla dinámica | La relevancia de los datos es importante, y se necesitan actualizaciones automáticas. | Snowflake gestiona las actualizaciones, pero los costes dependen de la frecuencia de las actualizaciones. |

| Tabla precalculada (mediante DBT, ETL, etc.). | Se requiere un control total sobre las actualizaciones de datos y el rendimiento. | Proporciona la máxima eficacia, pero añade complejidad a la gestión de datos. |

Utilizar una vista materializada

Una vista materializada precalcula y almacena los resultados de las consultas, lo que agiliza considerablemente la recuperación de datos.

CREATE MATERIALIZED VIEW my_fast_view AS

SELECT important_column_1, important_column_2

FROM my_raw_table;

Las vistas materializadas consumen almacenamiento adicional y deben actualizarse para mantener los datos al día. Puedes encontrar más información en la documentación de las vistas materializadas.

Utilizar una tabla dinámica

Si los datos cambian con frecuencia y las actualizaciones completas son demasiado lentas, una tabla dinámica permite a Snowflake gestionar las actualizaciones incrementales:

CREATE DYNAMIC TABLE my_dynamic_table

TARGET_LAG = '10 MINUTES'

WAREHOUSE = my_warehouse

AS SELECT important_column_1, important_column_2 FROM my_raw_table;

Snowflake gestiona automáticamente las actualizaciones incrementales en función de la configuración de TARGET_LAG. Puedes encontrar más información en la documentación de las tablas dinámicas.

Principales conclusiones

- Utilizar una vista para restringir los datos enviados a Datadog y optimizar el rendimiento de las consultas.

- Para consultas lentas, considerar el uso de una vista materializada, tabla dinámica o tabla precalculada para mejorar la eficiencia.

- Evaluar las compensaciones de costes y rendimiento antes de elegir una estrategia.

Siguiendo estas prácticas recomendadas, puedes garantizar una integración eficiente y rentable entre Snowflake y Datadog. Si necesitas ayuda para determinar la mejor opción para tu organización, ponte en contacto con el servicio de asistencia de Snowflake.

Solucionar problemas en tablas de referencia de Snowflake

- Los nombres de las tablas de referencia deben ser únicos en Datadog.

- Datadog no valida los nombres de tablas de Snowflake. Si tu tabla no aparece en Tablas de referencia, asegúrate de haber ingresado correctamente el nombre de la tabla de Snowflake.

- Si tu tabla sigue sin aparecer, revisa la sección Limitaciones de la documentación de la tabla de referencia para asegurarte de que tu tabla no corresponde a ninguna de esas categorías.

- En caso de problemas con la ingesta de Datadog, ponte en contacto con el servicio de asistencia de Datadog. Si tienes problemas con tu tabla de Snowflake, ponte en contacto con el servicio de asistencia de Snowflake.

Datos recopilados

Métricas

Eventos

La integración de Snowflake Web no incluye ningún evento.

Checks de servicio

La integración de Snowflake Web no incluye ningún check de servicio.

Solucionar problemas

¿Necesitas ayuda? Ponte en contacto con el servicio de asistencia de Datadog.

Check del Agent: Snowflake

El check del Agent de Snowflake ya no es compatible; se recomienda cambiar a la nueva integración de Snowflake para obtener funciones adicionales y un menor volumen de llamadas a la API para Snowflake.

Agent: información general

Este check monitoriza Snowflake a través del Datadog Agent. Snowflake es un almacén de datos analíticos SaaS y se ejecuta completamente en la infraestructura de la nube. Esta integración monitoriza el uso de crédito, la facturación, el almacenamiento, las métricas de consulta y más.

Agent: configuración

Sigue las instrucciones a continuación para instalar y configurar este check para un Agent que se ejecuta en un host.

Agent: instalación

El check de Snowflake está incluido en el paquete del Datadog Agent.

Nota: El check de Snowflake no está disponible en el Datadog Agent v6 con Python 2. Para utilizar Snowflake en el Agent v6, consulta Uso de Python 3 con el Datadog Agent v6 o actualiza al Agent v7.

Agent: configuración

Snowflake recomienda otorgar permisos a un rol alternativo como `SYSADMIN`. Lee más sobre cómo controlar el rol ACCOUNTADMIN para obtener más información.

Crea un rol y un usuario específicos de Datadog para monitorizar Snowflake. En Snowflake, ejecuta lo siguiente para crear un rol personalizado con acceso al esquema ACCOUNT_USAGE.

Nota: Por defecto, esta integración monitoriza la base de datos

SNOWFLAKEy el esquemaACCOUNT_USAGE. Consulta “Recopilación de datos de la organización” para obtener información sobre cómo monitorizar el esquemaORGANIZATION_USAGE. Esta base de datos está disponible por defecto y solo la pueden ver los usuarios con el rolACCOUNTADMINo cualquier rol otorgado por el ACCOUNTADMIN.use role ACCOUNTADMIN; grant imported privileges on database snowflake to role SYSADMIN; use role SYSADMIN;También puedes crear un rol

DATADOGpersonalizado con acceso aACCOUNT_USAGE.-- Create a new role intended to monitor Snowflake usage. create role DATADOG; -- Grant privileges on the SNOWFLAKE database to the new role. grant imported privileges on database SNOWFLAKE to role DATADOG; -- Grant usage to your default warehouse to the role DATADOG. grant usage on warehouse <WAREHOUSE> to role DATADOG; -- Create a user, skip this step if you are using an existing user. create user DATADOG_USER LOGIN_NAME = DATADOG_USER password = '<PASSWORD>' default_warehouse = <WAREHOUSE> default_role = DATADOG default_namespace = SNOWFLAKE.ACCOUNT_USAGE; -- Grant the monitor role to the user. grant role DATADOG to user <USER>;Edita el archivo

snowflake.d/conf.yaml, que se encuentra en la carpetaconf.d/en la raíz del directorio de configuración del Agent, para empezar a recopilar tus datos de rendimiento de Snowflake. Para conocer todas las opciones de configuración disponibles, consulta el snowflake.d/conf.yaml de ejemplo.## @param account - string - required ## Name of your account (provided by Snowflake), including the platform and region if applicable. ## For more information on Snowflake account names, ## see https://docs.snowflake.com/en/user-guide/connecting.html#your-snowflake-account-name # - account: <ORG_NAME>-<ACCOUNT_NAME> ## @param username - string - required ## Login name for the user. # username: <USER> ## @param password - string - required ## Password for the user # password: <PASSWORD> ## @param role - string - required ## Name of the role to use. ## ## By default, the SNOWFLAKE database is only accessible by the ACCOUNTADMIN role. Snowflake recommends ## configuring a role specific for monitoring: ## https://docs.snowflake.com/en/sql-reference/account-usage.html#enabling-account-usage-for-other-roles # role: <ROLE> ## @param min_collection_interval - number - optional - default: 15 ## This changes the collection interval of the check. For more information, see: ## https://docs.datadoghq.com/developers/write_agent_check/#collection-interval ## ## NOTE: Most Snowflake ACCOUNT_USAGE views are populated on an hourly basis, ## so to minimize unnecessary queries, set the `min_collection_interval` to 1 hour. # min_collection_interval: 3600 # @param disable_generic_tags - boolean - optional - default: false # Generic tags such as `cluster` will be replaced by <INTEGRATION_NAME>_cluster to avoid # getting mixed with other integration tags. # disable_generic_tags: trueIn the default `conf.yaml`, themin_collection_intervalis 1 hour. Snowflake metrics are aggregated by day, you can increase the interval to reduce the number of queries.Note : Snowflake ACCOUNT_USAGE views have a known latency of 45 minutes to 3 hours.

Recopilación de datos de la organización

Por defecto, esta integración monitoriza el esquema ACCOUNT_USAGE, pero se puede configurar para monitorizar métricas a nivel de la organización.

Para recopilar métricas de la organización, cambia el campo del esquema a ORGANIZATION_USAGE y aumenta min_collection_interval a 43200 en la configuración de la integración. Esto reduce el número de consultas a Snowflake, ya que la mayoría de las consultas de la organización tienen una latencia de hasta 24 horas.

Nota: Para monitorizar las métricas de la organización, tu user debe tener el rol ORGADMIN.

- schema: ORGANIZATION_USAGE

min_collection_interval: 43200

De forma predeterminada, solo se habilitan algunas métricas de la organización. Para recopilar todas las métricas de la organización disponibles, utiliza la opción de configuración metric_groups:

metric_groups:

- snowflake.organization.warehouse

- snowflake.organization.currency

- snowflake.organization.credit

- snowflake.organization.storage

- snowflake.organization.contracts

- snowflake.organization.balance

- snowflake.organization.rate

- snowflake.organization.data_transfer

Además, puedes monitorizar las métricas de la cuenta y de la organización al mismo tiempo:

instances:

- account: example-inc

username: DATADOG_ORG_ADMIN

password: "<PASSWORD>"

role: SYSADMIN

schema: ORGANIZATION_USAGE

database: SNOWFLAKE

min_collection_interval: 43200

- account: example-inc

username: DATADOG_ACCOUNT_ADMIN

password: "<PASSWORD>"

role: DATADOG_ADMIN

schema: ACCOUNT_USAGE

database: SNOWFLAKE

min_collection_interval: 3600

Recopilación de datos para múltiples entornos

Si deseas recopilar datos para varios entornos de Snowflake, añade cada entorno como una instancia en tu archivo snowflake.d/conf.yaml. Por ejemplo, si necesitas recopilar datos para dos usuarios llamados DATADOG_SYSADMIN y DATADOG_USER:

instances:

- account: example-inc

username: DATADOG_SYSADMIN

password: "<PASSWORD>"

role: SYSADMIN

database: EXAMPLE-INC

- account: example-inc

username: DATADOG_USER

password: "<PASSWORD>"

role: DATADOG_USER

database: EXAMPLE-INC

Configuración del proxy

Snowflake recomienda configurar variables de entorno para configuraciones de proxy.

También puedes configurar proxy_host, proxy_port, proxy_user y proxy_password bajo init_config en snowflake.d/conf.yaml.

Nota: Snowflake formatea automáticamente las configuraciones de proxy y configura variables de entorno de proxy estándar. Estas variables también afectan todas las solicitudes de integraciones, incluidos los orquestadores como Docker, ECS y Kubernetes.

Conectividad privada a la configuración de Snowflake

Si la conectividad privada (como AWS PrivateLink) está habilitada en Snowflake, puedes configurar la integración Snowflake actualizando la opción de configuración account con el siguiente formato:

- account: <ACCOUNT>.<REGION_ID>.privatelink

Consultas personalizadas de Snowflake

La integración Snowflake admite consultas personalizadas. Por defecto, la integración se conecta a la base de datos compartida SNOWFLAKE y al esquema ACCOUNT_USAGE.

Para ejecutar consultas personalizadas en un esquema o una base de datos diferentes, añade otra instancia al snowflake.d/conf.yaml de ejemplo y especifica las opciones database y schema.

Asegúrate de que el usuario y el rol tienen acceso a la base de datos o al esquema especificados.

Opciones de configuración

La opción custom_queries tiene las siguientes opciones:

| Opción | Obligatorio | Descripción |

|---|---|---|

| query | Sí | Este es el SQL que se va a ejecutar. Puede ser una sentencia simple o un script de varias líneas. Se evalúan todas las filas de los resultados. Utiliza la barra vertical si requieres un script de varias líneas. |

| columns | Sí | Se trata de una lista que representa cada columna ordenada secuencialmente de izquierda a derecha. Hay 2 datos necesarios: - name**: es el sufijo que se añade a metric_prefix para formar el nombre completo de la métrica. Si se especifica type como tag, la columna se aplica como una etiqueta a cada métrica recopilada por esta consulta.- type: este es el método de envío (gauge, count, rate, etc.). También se puede definir como tag para etiquetar cada métrica de la fila con el nombre y el valor (<NAME>:<ROW_VALUE>) del elemento de esta columna. |

| tags | No | Una lista de etiquetas estáticas que pueden aplicarse a las métricas. |

Notas:

Al menos uno de los elementos definidos en

columnsdebería ser un tipo de métrica (gauge,count,rate).El número de elementos en las columnas debe ser igual a la cantidad de columnas devueltas en la consulta.

El orden en que se definen los elementos en

columnsdebe ser el mismo orden en que se devuelven en la consulta.

custom_queries:

- query: select F3, F2, F1 from Table;

columns:

- name: f3_metric_alias

type: gauge

- name: f2_tagkey

type: tag

- name: f1_metric_alias

type: count

tags:

- test:snowflake

Ejemplo

El siguiente ejemplo es una consulta que cuenta todas las consultas de la vista QUERY_HISTORY, etiquetadas por nombres de base de datos, esquema y almacén.

select count(*), DATABASE_NAME, SCHEMA_NAME, WAREHOUSE_NAME from QUERY_HISTORY group by 2, 3, 4;

Configuración de una consulta personalizada

La configuración de una consulta personalizada en instances tiene el siguiente aspecto:

custom_queries:

- query: select count(*), DATABASE_NAME, SCHEMA_NAME, WAREHOUSE_NAME from QUERY_HISTORY group by 2, 3, 4;

columns:

- name: query.total

type: gauge

- name: database_name

type: tag

- name: schema_name

type: tag

- name: warehouse_name

type: tag

tags:

- test:snowflake

Agent: validación

Ejecuta el subcomando de estado del Agent y busca snowflake en la sección Checks.

Agent: datos recopilados

snowflake.query.*, snowflake.billing.*, snowflake.storage.* y snowflake.logins.*.Si quieres recopilar métricas de otros grupos de métricas, consulta el archivo de configuración de ejemplo de esta integración.

Agent: métricas

Consulta Métricas para obtener una lista de las métricas que proporciona este check.

Agent: eventos

Snowflake no incluye ningún evento.

Agent: checks de servicio

snowflake.can_connect

Devuelve CRITICAL si el check no puede autenticar las credenciales de Snowflake. En caso contrario, devuelve OK.

Estados: ok, crítico

Agent: solucionar problemas

¿Necesitas ayuda? Ponte en contacto con el servicio de asistencia de Datadog.

Referencias adicionales

Documentación útil adicional, enlaces y artículos: