- Esenciales

- Empezando

- Agent

- API

- Rastreo de APM

- Contenedores

- Dashboards

- Monitorización de bases de datos

- Datadog

- Sitio web de Datadog

- DevSecOps

- Gestión de incidencias

- Integraciones

- Internal Developer Portal

- Logs

- Monitores

- OpenTelemetry

- Generador de perfiles

- Session Replay

- Security

- Serverless para Lambda AWS

- Software Delivery

- Monitorización Synthetic

- Etiquetas (tags)

- Workflow Automation

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Build an Integration with Datadog

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un dashboard de integración

- Create a Monitor Template

- Crear una regla de detección Cloud SIEM

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- OpenTelemetry

- Administrator's Guide

- API

- Partners

- Aplicación móvil de Datadog

- DDSQL Reference

- CoScreen

- CoTerm

- Remote Configuration

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Reference Tables

- Hojas

- Monitores y alertas

- Watchdog

- Métricas

- Bits AI

- Internal Developer Portal

- Error Tracking

- Explorador

- Estados de problemas

- Detección de regresión

- Suspected Causes

- Error Grouping

- Bits AI Dev Agent

- Monitores

- Issue Correlation

- Identificar confirmaciones sospechosas

- Auto Assign

- Issue Team Ownership

- Rastrear errores del navegador y móviles

- Rastrear errores de backend

- Manage Data Collection

- Solucionar problemas

- Guides

- Change Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Status Pages

- Gestión de eventos

- Gestión de casos

- Actions & Remediations

- Infraestructura

- Cloudcraft

- Catálogo de recursos

- Universal Service Monitoring

- Hosts

- Contenedores

- Processes

- Serverless

- Monitorización de red

- Cloud Cost

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Recommendations

- Code Origin for Spans

- Observabilidad del servicio

- Endpoint Observability

- Instrumentación dinámica

- Live Debugger

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Límites de tasa del Agent

- Métricas de APM del Agent

- Uso de recursos del Agent

- Logs correlacionados

- Stacks tecnológicos de llamada en profundidad PHP 5

- Herramienta de diagnóstico de .NET

- Cuantificación de APM

- Go Compile-Time Instrumentation

- Logs de inicio del rastreador

- Logs de depuración del rastreador

- Errores de conexión

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Setting Up Amazon DocumentDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Exploring Database Schemas

- Exploring Recommendations

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Data Observability

- Experiencia digital

- Real User Monitoring

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Análisis de productos

- Entrega de software

- CI Visibility

- CD Visibility

- Deployment Gates

- Test Visibility

- Configuración

- Network Settings

- Tests en contenedores

- Repositories

- Explorador

- Monitores

- Test Health

- Flaky Test Management

- Working with Flaky Tests

- Test Impact Analysis

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Code Coverage

- Quality Gates

- Métricas de DORA

- Feature Flags

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Code Security

- Cloud Security Management

- Application Security Management

- Workload Protection

- Sensitive Data Scanner

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- CloudPrem

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Ayuda

Habilitar Data Jobs Monitoring para Spark en Amazon EMR

Este producto no es compatible con el sitio Datadog seleccionado. ().

Data Jobs Monitoring ofrece visibilidad del rendimiento y la fiabilidad de las aplicaciones Apache Spark en Amazon EMR.

Requisitos

Se requiere Amazon EMR versión 6.0.1 o posterior.

Configuración

Sigue estos pasos para habilitar Data Jobs Monitoring para Amazon EMR.

- Almacena tu clave de API Datadog en AWS Secrets Manager (recomendado).

- Concede permisos al perfil de la instancia EC2 EMR.

- Crea y configura tu clúster EMR.

- Especifica el etiquetado de servicios por aplicación Spark.

Almacenar tu clave de API Datadog en AWS Secrets Manager (recomendado)

- Toma nota de tu clave de API Datadog.

- En AWS Secrets Manager, elige Almacenar un nuevo secreto.

- En Tipo de secreto, selecciona Otro tipo de secreto.

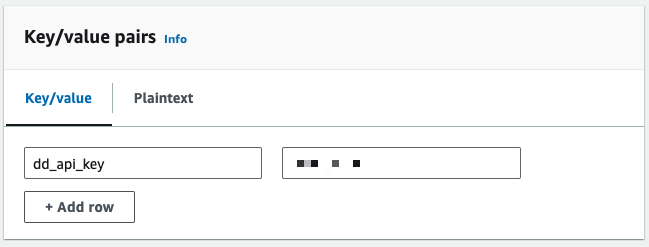

- En Pares clave/valor, añade tu clave de API Datadog como par clave-valor, donde la clave es

dd_api_key. - A continuación, haz clic en Next (Siguiente).

- En la página Configurar secreto, introduce un Nombre secreto. Puedes utilizar

datadog/dd_api_key. A continuación, haz clic en Next (Siguiente). - En la página Configurar rotación, puedes activar opcionalmente la rotación automática. A continuación, haz clic en Next (Siguiente).

- En la página Revisar, revisa tus datos secretos. A continuación, haz clic en Store (Almacenar).

- En AWS Secrets Manager, abre el secreto que creaste. Toma nota del ARN secreto.

Concede permisos al perfil de la instancia EC2 EMR

El perfil de la instancia EC2 EMR es un rol IAM que se asigna a cada instancia EC2 de un clúster Amazon EMR cuando se lanza la instancia. Sigue la guía de Amazon para preparar este rol en función de las necesidades de tu aplicación de interactuar con otros servicios AWS. Los siguientes permisos adicionales pueden ser necesarios para Data Jobs Monitoring.

Permisos para obtener el valor secreto utilizando AWS Secrets Manager

Estos permisos son necesarios si utilizas AWS Secrets Manager.

- En tu consola de AWS IAM, haz clic en Access management > Roles (Gestión de acceso > Roles) en la barra de navegación izquierda.

- Haz clic en el rol IAM que quieres utilizar como perfil de la instancia para tu clúster EMR.

- En la página siguiente, en la pestaña Permisos, busca la sección Políticas de permisos y haz clic en Add permissions > Create inline policy (Añadir permisos > Crear política en línea).

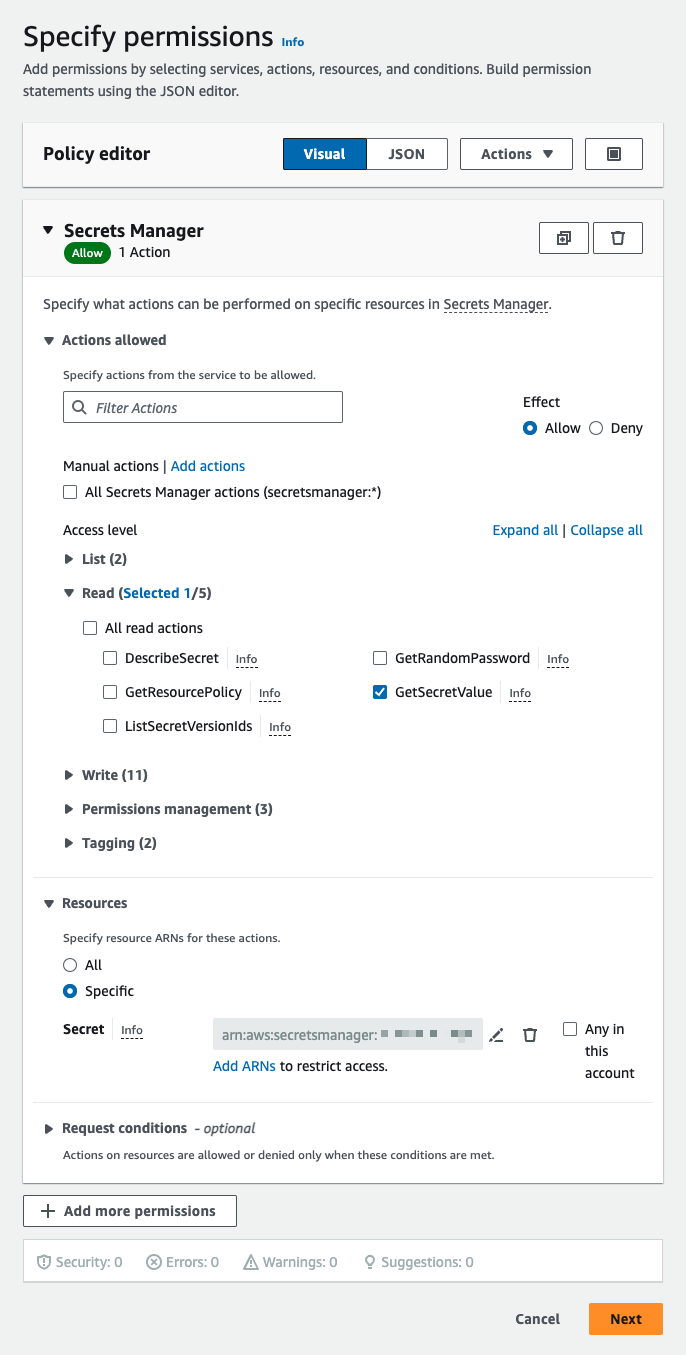

- En la página Especificar permisos, busca la sección Seleccionar un servicio. En servicio, selecciona Secrets Manager.

- A continuación, en Acciones permitidas, selecciona

GetSecretValue. Se trata de una acción de Lectura. - En Recursos, selecciona Específicos. A continuación, junto a Secreto, haz clic en Add ARNs (Añadir ARN) y añade el ARN del secreto que creaste en el primer paso de esta página.

- Haz clic en Next (Siguiente).

- A continuación, en Acciones permitidas, selecciona

- En la página siguiente, dale un nombre a tu política. A continuación, haz clic en Create policy (Crear política).

Permisos para describir clústeres

Estos permisos son necesarios si NO utilizas el rol por defecto,

EMR_EC2_DefaultRole.- En tu consola de AWS IAM, haz clic en Access management > Roles (Gestión de acceso > Roles) en la barra de navegación izquierda.

- Haz clic en el rol IAM que quieres utilizar como perfil de la instancia para tu clúster EMR.

- En la página siguiente, en la pestaña Permisos, busca la sección Políticas de permisos y haz clic en Add permissions > Create inline policy (Añadir permisos > Crear política en línea).

- En la página Especificar permisos, activa la pestaña JSON.

- A continuación, copia y pega la siguiente política en el Editor de políticas.

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "elasticmapreduce:ListBootstrapActions", "elasticmapreduce:ListInstanceFleets", "elasticmapreduce:DescribeCluster", "elasticmapreduce:ListInstanceGroups" ], "Resource": [ "*" ] } ] }- Haz clic en Next (Siguiente).

- En la página siguiente, dale un nombre a tu política. A continuación, haz clic en Create policy (Crear política).

Toma nota del nombre del rol IAM que planeas utilizar como perfil de la instancia para tu clúster EMR.

Crear y configurar tu clúster EMR

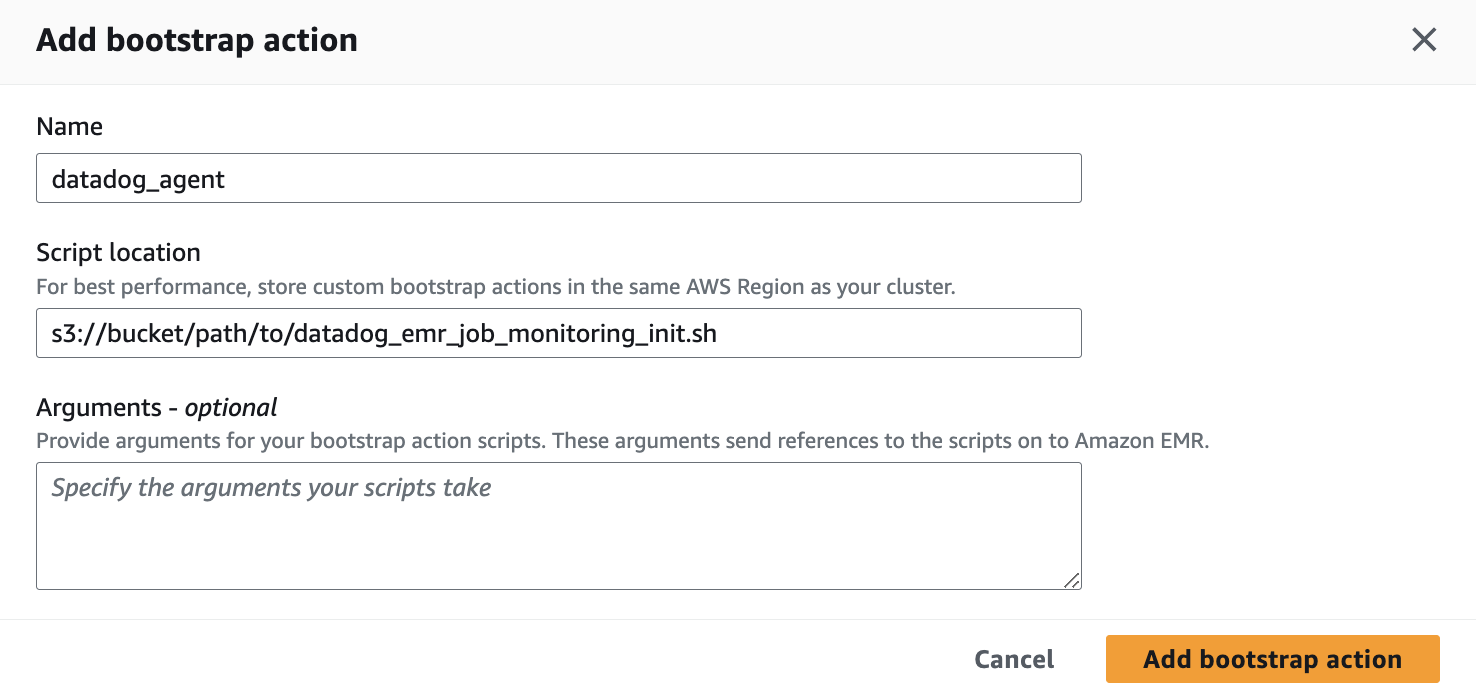

Cuando crees un nuevo clúster EMR en la consola de Amazon EMR, añade una acción de arranque en la página Crear clúster:

Guarda el siguiente script en un bucket S3 que tu clúster EMR pueda leer. Toma nota de la ruta a este script.

#!/bin/bash # Set required parameter DD_SITE export DD_SITE=# Set required parameter DD_API_KEY with Datadog API key. # The commands below assumes the API key is stored in AWS Secrets Manager, with the secret name as datadog/dd_api_key and the key as dd_api_key. # IMPORTANT: Modify if you choose to manage and retrieve your secret differently. SECRET_NAME=datadog/dd_api_key export DD_API_KEY=$(aws secretsmanager get-secret-value --secret-id $SECRET_NAME | jq -r .SecretString | jq -r '.["dd_api_key"]') # Optional: uncomment to send spark driver and worker logs to Datadog # export DD_EMR_LOGS_ENABLED=true # Download and run the latest init script curl -L https://install.datadoghq.com/scripts/install-emr.sh > djm-install-script; bash djm-install-script || trueEl script anterior define los parámetros necesarios y descarga y ejecuta el script init más reciente para Data Jobs Monitoring en EMR. Si quieres vincular tu script a una versión específica, puedes sustituir el nombre del archivo en la URL por

install-emr-0.10.0.shpara utilizar la versión0.10.0, por ejemplo. El código fuente utilizado para generar este script y los cambios entre versiones de script se pueden encontrar en el repositorio del Datadog.En la página Crear clúster, busca la sección Acciones de arranque. Haz clic en Add (Añadir) para abrir el cuadro de diálogo Añadir acción de bootstrap.

- En Nombre, colócale un nombre a tu acción de arranque. Puedes utilizar

datadog_agent. - En Localización del script, introduce la ruta donde almacenaste el script init en S3.

- Haz clic en Add bootstrap action (Añadir acción de arranque).

- En Nombre, colócale un nombre a tu acción de arranque. Puedes utilizar

En la página Crear clúster, busca la sección Roles de Identity and Access Management (IAM). En el menú desplegable perfil de instancia, selecciona el rol IAM al que hayas concedido permisos en Conceder permisos al perfil de la instancia EC2 EMR.

Cuando se crea tu clúster, esta acción de arranque instala el Datadog Agent y descarga el rastreador Java en cada nodo del clúster.

Especificar el etiquetado de servicios por cada aplicación Spark

El etiquetado te permite filtrar, agregar y comparar mejor tu telemetría en Datadog. Puedes configurar etiquetas (tags) pasando las opciones -Ddd.service, -Ddd.env, -Ddd.version y -Ddd.tags a las propiedades extraJavaOptions de tu controlador y ejecutor Spark.

En Datadog, el nombre de cada trabajo corresponde al valor que definiste para -Ddd.servicio.

spark-submit \

--conf spark.driver.extraJavaOptions="-Ddd.service=<JOB_NAME> -Ddd.env=<ENV> -Ddd.version=<VERSION> -Ddd.tags=<KEY_1>:<VALUE_1>,<KEY_2:VALUE_2>" \

--conf spark.executor.extraJavaOptions="-Ddd.service=<JOB_NAME> -Ddd.env=<ENV> -Ddd.version=<VERSION> -Ddd.tags=<KEY_1>:<VALUE_1>,<KEY_2:VALUE_2>" \

application.jar

Validación

En Datadog, consulta la página Data Jobs Monitoring para ver una lista de todos tus trabajos de procesamiento de datos.

Solucionar problemas

If you don’t see any data in DJM after installing the product, follow these steps.

The init script installs the Datadog Agent. To make sure it is properly installed, ssh into the cluster and run the Agent status command:

sudo datadog-agent status

Configuración avanzada

Etiquetar tramos (spans) en tiempo de ejecución

You can set tags on Spark spans at runtime. These tags are applied only to spans that start after the tag is added.

// Add tag for all next Spark computations

sparkContext.setLocalProperty("spark.datadog.tags.key", "value")

spark.read.parquet(...)

To remove a runtime tag:

// Remove tag for all next Spark computations

sparkContext.setLocalProperty("spark.datadog.tags.key", null)

Referencias adicionales

Más enlaces, artículos y documentación útiles: